Unternehmen in allen Branchen führen dieses Jahr KI-Dienste ein. Für Microsoft, Oracle, Perplexity, Snap und Hunderte anderer führender Unternehmen ist die Nutzung der NVIDIA AI-Inferenzplattform – ein Full-Stack-Ansatz bestehend aus erstklassigen Chips, Systemen und Software – der Schlüssel, um Inferenz mit hohem Durchsatz und geringer Latenz zu erzielen und großartige Benutzererlebnisse bei gleichzeitigen Kostensenkungen zu ermöglichen.

Fortschritte von NVIDIA bei der Optimierung von Inferenzsoftware und die NVIDIA Hopper-Plattform unterstützen Branchen bei der Bereitstellung der neuesten generativen KI-Modelle, sodass sie für hervorragende Benutzererlebnisse sorgen und gleichzeitig ihre Gesamtbetriebskosten reduzieren können. Die Plattform Hopper ermöglicht bei Inferenz-Workloads zudem eine bis zu 15-fach höhere Energieeffizienz im Vergleich zu vorherigen Generationen.

KI-Inferenz ist bekanntermaßen komplex, da viele Schritte erforderlich sind, um ein optimales Gleichgewicht zwischen Durchsatz und Benutzererlebnis zu erreichen.

Das zugrunde liegende Ziel ist jedoch einfach: mehr Token zu geringeren Kosten zu generieren. Token repräsentieren Wörter in einem LLM-System (Large Language Model). Da KI-Inferenzdienste in der Regel für jede Million generierte Token Gebühren erheben, stellt dieses Ziel die sichtbarste Rentabilität für KI-Investitionen und den Energieverbrauch pro Aufgabe dar.

Eine Full-Stack-Softwareoptimierung ist der Schlüssel zur Verbesserung der KI-Inferenzleistung und zur Erreichung dieses Ziels.

Kostengünstiger Benutzerdurchsatz

Unternehmen tun sich oft schwer, ein Gleichgewicht zwischen Leistung und Kosten von Inferenz-Workloads zu finden. Während manche Kunden oder Anwendungsfälle mit sofort verfügbaren oder gehosteten Modellen arbeiten können, erfordern andere möglicherweise Anpassungen. NVIDIA-Technik vereinfacht die Modellbereitstellung und optimiert gleichzeitig Kosten und Leistung von KI-Inferenz-Workloads. Darüber hinaus können Kunden mit den von ihnen bereitgestellten Modellen von Flexibilität und Anpassungsmöglichkeiten profitieren.

NVIDIA NIM-Microservices, NVIDIA Triton Inference Server und die NVIDIA TensorRT-Bibliothek gehören zu den Inferenzlösungen, die NVIDIA anbietet, um den Bedürfnissen von Benutzern rundum gerecht zu werden:

- NVIDIA NIM-Inferenz-Microservices sind für die schnelle Bereitstellung von Foundation-Modellen in jeder Infrastruktur – ob Cloud, Rechenzentrum, Edge oder Workstation – vorgefertigt und leistungsoptimiert.

- NVIDIA Triton Inference Server, eines der beliebtesten Open-Source-Projekte des Unternehmens, erlaubt es Benutzern, jedes beliebige Modell zu verpacken und bereitzustellen – und zwar unabhängig vom KI-Framework, mit dem es trainiert wurde.

- NVIDIA TensorRT ist eine leistungsstarke Deep-Learning-Inferenzbibliothek, die Laufzeit- und Modelloptimierungen umfasst, um für Produktionsanwendungen Inferenz mit geringer Latenz und hohem Durchsatz zu ermöglichen.

Die NVIDIA AI Enterprise-Softwareplattform ist bei allen wichtigen Cloud-Marktplätzen verfügbar, umfasst alle eben genannten Lösungen und bietet Support, Stabilität, Verwaltbarkeit und Sicherheit auf Unternehmensniveau.

Mit der Framework-unabhängigen NVIDIA AI-Inferenzplattform können Unternehmen bei Produktivität, Entwicklung, Infrastruktur und Einrichtungskosten viel Geld sparen. Durch den Einsatz von NVIDIA-Technik können Unternehmen zudem ihre Umsätze steigern, indem Ausfallzeiten und betrügerische Transaktionen verhindert, die Konversionsraten im E-Commerce erhöht sowie neue, KI-gestützte Einnahmequellen generiert werden.

Cloudbasierte LLM-Inferenz

Für eine vereinfachte Bereitstellung von LLMs hat NVIDIA eng mit den einzelnen führenden Cloud-Service-Anbietern zusammengearbeitet, um dafür zu sorgen, dass sich die NVIDIA-Inferenzplattform in der Cloud mit nur wenig oder gar keinem Code nahtlos bereitstellen lässt. NVIDIA NIM ist in Cloud-native Dienste integriert, wie zum Beispiel:

- Amazon SageMaker AI, Amazon Bedrock Marketplace, Amazon Elastic Kubernetes Service

- Google Cloud’s Vertex AI, Google Kubernetes Engine

- Microsoft Azure AI Foundry (in Kürze verfügbar), Azure Kubernetes Service

- Data-Science-Tools von Oracle Cloud Infrastructure, Oracle Cloud Infrastructure Kubernetes Engine

Darüber hinaus ist der NVIDIA Triton Inference Server für individuelle Inferenzbereitstellungen tief in alle wichtigen Cloud-Service-Anbieter integriert.

Die Bereitstellung von NVIDIA Triton mit der OCI Data Science-Plattform ist beispielsweise so leicht wie das Aktivieren eines Schalters in den Befehlszeilenargumenten bei der Modellbereitstellung, wodurch sofort ein NVIDIA Triton Inferenz-Endpunkt gestartet wird.

Ebenso können Benutzer NVIDIA Triton mit Azure Machine Learning entweder per No-Code-Bereitstellung über Azure Machine Learning Studio oder per Full-Code-Bereitstellung mit der Azure Machine Learning CLI bereitstellen. AWS ermöglicht eine Ein-Klick-Bereitstellung für NVIDIA NIM über SageMaker Marketplace, während Google Cloud eine Bereitstellungsoption mit einem Klick in Google Kubernetes Engine (GKE) bietet. Google Cloud verfügt über eine Bereitstellungsoption mit einem Klick in Google Kubernetes Engine, während AWS NVIDIA Triton in seinen AWS Deep-Learning-Containern bereitstellt.

Die NVIDIA AI-Inferenzplattform nutzt außerdem gängige Kommunikationsmethoden, um KI-Vorhersagen zu liefern, und passt sich innerhalb einer cloudbasierten Infrastruktur automatisch an wachsende und sich ändernde Anforderungen von Benutzern an.

Von der Beschleunigung von LLMs über die Verbesserung kreativer Workflows bis hin zur Transformation des Vertragsmanagements: die KI-Inferenzplattform von NVIDIA sorgt in verschiedensten Branchen für reale Vorteile. Erfahren Sie, wie die folgenden Unternehmen durch Zusammenarbeit und Innovation ein neues Maß an Effizienz und Skalierbarkeit erreichen.

Verarbeitung von 400 Millionen Suchabfragen monatlich mit Perplexity AI

Perplexity AI, eine KI-gestützte Suchmaschine, bearbeitet monatlich mehr als 435 Millionen Abfragen. Jede Abfrage umfasst mehrere KI-Inferenzanforderungen. Um diesem Bedarf gerecht zu werden, nutzte das Team von Perplexity AI NVIDIA H100-GPUs, Triton Inference Server und TensorRT-LLM.

Perplexity unterstützt mehr als 20 KI-Modelle, darunter Varianten von Llama 3 wie 8B und 70B, und verarbeitet verschiedene Aufgaben wie Suchanfragen, Zusammenfassungen und die Beantwortung von Fragen. Durch die Verwendung kleinerer Klassifizierungsmodelle zur Weiterleitung von Aufgaben an GPU-Pods, die von NVIDIA Triton verwaltet werden, bietet das Unternehmen einen kosteneffizienten, reaktionsschnellen Service unter Einhaltung strenger Vereinbarungen zur Dienstgüte an.

Durch Modellparallelität, die LLMs auf GPUs aufteilt, konnte Perplexity eine Kostensenkung um den Faktor 3 bei gleichzeitiger Aufrechterhaltung niedriger Latenz und hoher Genauigkeit erzielen. Dieses Best-Practice-Framework zeigt, wie IT-Teams mit durch NVIDIA-Technik beschleunigtem Computing wachsende KI-Anforderungen erfüllen, Gesamtbetriebskosten senken und nahtlos skalieren können.

Verkürzung von Reaktionszeiten mit Recurrent Drafter (ReDrafter)

Fortschritte in der Open-Source-Forschung tragen zur Demokratisierung von KI-Inferenz bei. Vor kurzem hat NVIDIA ReDrafter, einen von Apple veröffentlichten Open-Source-Ansatz für spekulative Dekodierung, in NVIDIA TensorRT-LLM integriert.

ReDrafter verwendet kleinere „Draft“-Module, um Token parallel vorherzusagen, die dann vom Hauptmodell validiert werden. Dieses Verfahren reduziert die Reaktionszeiten von LLMs erheblich, insbesondere in Zeiten mit geringem Datenverkehr.

Transformation des Vertragsmanagements mit Docusign

Docusign, ein führender Anbieter im Bereich digitale Vertragsverwaltung, wandte sich an NVIDIA, um seine Plattform für intelligentes Vertragsmanagement zu optimieren. Mit über 1,5 Millionen Kunden weltweit musste Docusign seinen Durchsatz optimieren, die Infrastrukturkosten verwalten und gleichzeitig KI-gestützte Erkenntnisse bereitstellen.

NVIDIA Triton stellte eine einheitliche Inferenzplattform für alle Frameworks bereit, um die Markteinführung zu beschleunigen und die Produktivität zu steigern, indem Vertragsdaten in umsetzbare Erkenntnisse transformiert werden. Die Einführung der NVIDIA-Inferenzplattform durch Docusign unterstreicht die positiven Auswirkungen einer skalierbaren KI-Infrastruktur auf das Kundenerlebnis und die betriebliche Effizienz.

„NVIDIA Triton erleichtert uns das Leben“, so Alex Zakhvatov, Senior Product Manager bei Docusign. „Wir müssen für unsere KI-Modelle keine maßgeschneiderten, Framework-spezifischen Inferenzserver mehr bereitstellen. Wir nutzen Triton als einheitlichen Inferenzserver für alle KI-Frameworks und verwenden die Lösung zudem, um das richtige Produktionsszenario zu ermitteln und so Kosten und Aufwand bei der Entwicklung zu reduzieren.“

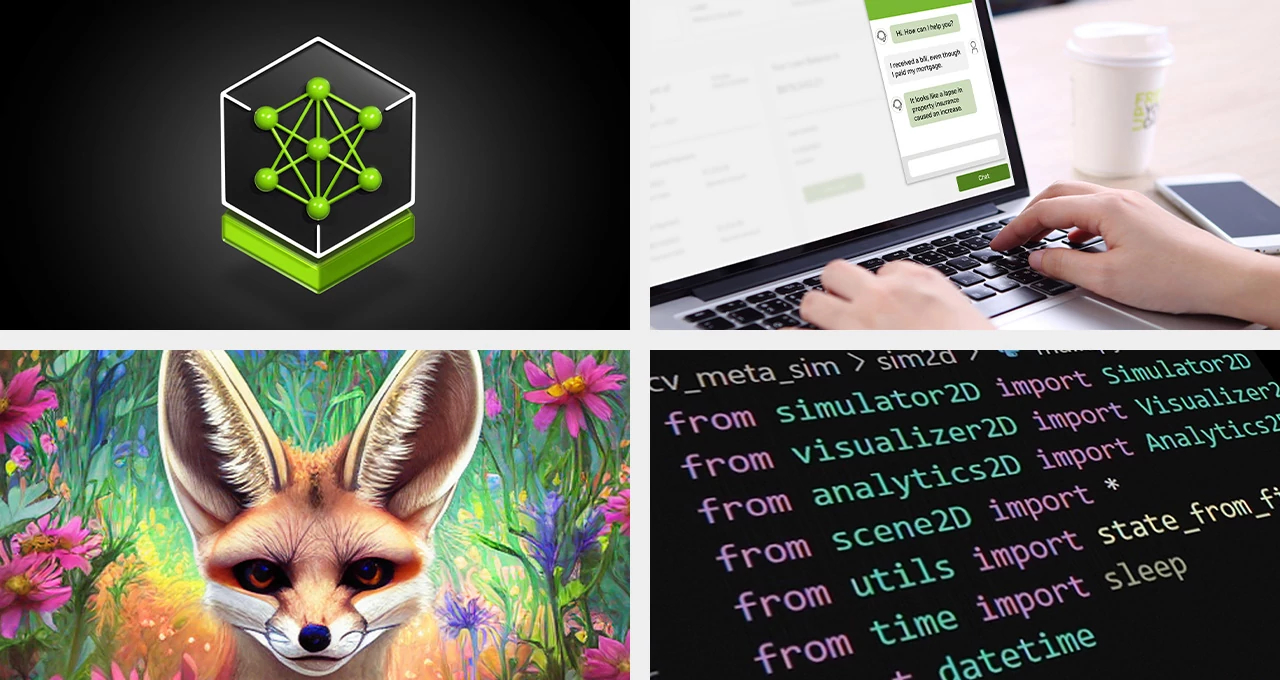

Verbesserung des Kundenservices in der Telekommunikationsbranche mit Amdocs

Amdocs, ein führender Anbieter von Software und Dienstleistungen für Kommunikations- und Medienanbieter, hat amAIz entwickelt, eine domänenspezifische generative KI-Plattform für Telekommunikationsunternehmen, die als offenes, sicheres, kosteneffizientes und LLM-agnostisches Framework dient. Amdocs nutzt NVIDIA DGX Cloud und NVIDIA AI Enterprise-Software, um Lösungen anzubieten, die auf kommerziell verfügbaren LLMs sowie auf an Domänen angepassten Modellen basieren, damit Dienstanbieter generative KI-Anwendungen für Unternehmen entwickeln und bereitstellen können.

Mit NVIDIA NIM konnte Amdocs die Zahl der für implementierte Anwendungsfälle verbrauchten Token bei der Vorverarbeitung von Daten um bis zu 60 % und beim Inferenzieren um 40 % reduzieren. Das Unternehmen bietet somit eine gleiche Genauigkeit zu deutlich niedrigeren Kosten pro Token, abhängig von verschiedenen Faktoren und verwendeten Volumina. Durch die Zusammenarbeit konnte außerdem die Abfragelatenz um etwa 80 % gesenkt werden, was dafür sorgt, dass Endbenutzer Antworten in nahezu Echtzeit erhalten. Diese Beschleunigung verbessert Benutzererlebnisse im Handel, im Kundenservice, im Betrieb und darüber hinaus.

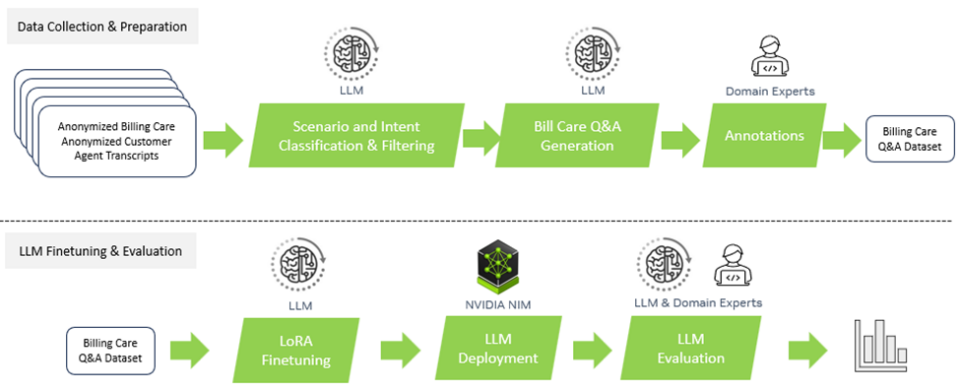

Revolutionierung des Einzelhandels mit KI in Snap

Der Kauf des perfekten Outfits ist dank der Screenshop-Funktion von Snap einfacher denn je. Diese in Snapchat integrierte KI-gestützte Funktion hilft Nutzern dabei, Modeartikel zu finden, die sie auf Fotos sehen. NVIDIA Triton spielte eine entscheidende Rolle bei der Unterstützung der Screenshop-Pipeline, die Bilder mit verschiedenen Frameworks verarbeitet (darunter mit TensorFlow und PyTorch).

Durch das Konsolidieren seiner Pipeline in einer zentralen Inferenz-Bereitstellungsplattform konnte Snap die Entwicklungsdauer und -kosten erheblich reduzieren und kann gleichzeitig für eine nahtlose Bereitstellung überarbeiteter Modelle sorgen. Das Ergebnis: ein reibungsloses Benutzererlebnis, das durch KI unterstützt wird.

„Wir wollten keine eigenen Inferenz-Bereitstellungsplattformen für unsere Screenshop-Pipeline einsetzen, eine TF-Bereitstellungsplattform für TensorFlow und eine TorchServe-Plattform für PyTorch“, erklärt Ke Ma, Ingenieur für maschinelles Lernen bei Snap. „Das Framework-agnostische Design von Triton und der Support für unterschiedliche Backends wie TensorFlow, PyTorch und ONNX haben uns voll überzeugt. Dadurch konnten wir unsere durchgängige Pipeline mit einer einzigen Inferenz-Bereitstellungsplattform bereitstellen, was die entsprechenden Kosten und die Anzahl der Tage, die Entwickler für die Aktualisierung unserer Modelle in der Produktion brauchen, deutlich reduziert hat.“

Nach der erfolgreichen Einführung des Screenshop-Dienstes in NVIDIA Triton nutzten Ma und sein Team NVIDIA TensorRT, um die Leistung des Systems weiter zu verbessern. Durch die Anwendung der Standardeinstellungen von NVIDIA TensorRT während der Kompilierung konnte das Screenshop-Team umgehend einen 3-fachen Anstieg des Durchsatzes verzeichnen, was zu einer geschätzten Kostensenkung von beeindruckenden 66 % führte.

Finanzielle Freiheit durch KI mithilfe von Wealthsimple

Wealthsimple, eine kanadische Investmentplattform, die Vermögen im Wert von mehr als 30 Milliarden kanadischen Dollar verwaltet, hat ihren Ansatz für maschinelles Lernen mit der KI-Inferenzplattform von NVIDIA neu definiert. Durch die Standardisierung seiner Infrastruktur konnte Wealthsimple die Bereitstellungszeit für Modelle von Monaten auf weniger als 15 Minuten verkürzen, wodurch Ausfallzeiten eliminiert und Teams in die Lage versetzt wurden, maschinelles Lernen als Service bereitzustellen.

Dank der Einführung von NVIDIA Triton und der Ausführung seiner Modelle über AWS erzielte Wealthsimple eine Verfügbarkeit von 99,999 %, was lückenlose Vorhersagen für mehr als 145 Millionen Transaktionen jährlich möglich macht. Diese Transformation zeigt, wie eine robuste KI-Infrastruktur Finanzdienstleistungen nachhaltig revolutionieren kann.

„Die KI-Inferenzplattform von NVIDIA ist der Dreh- und Angelpunkt hinter der ML-Erfolgsgeschichte unseres Unternehmens. Sie hat unsere Modellbereitstellung revolutioniert, Ausfallzeiten reduziert und es uns erlaubt, Kunden einen unvergleichlichen Service zu bieten“, so Mandy Gu, Senior Manager für Softwareentwicklung bei Wealthsimple.

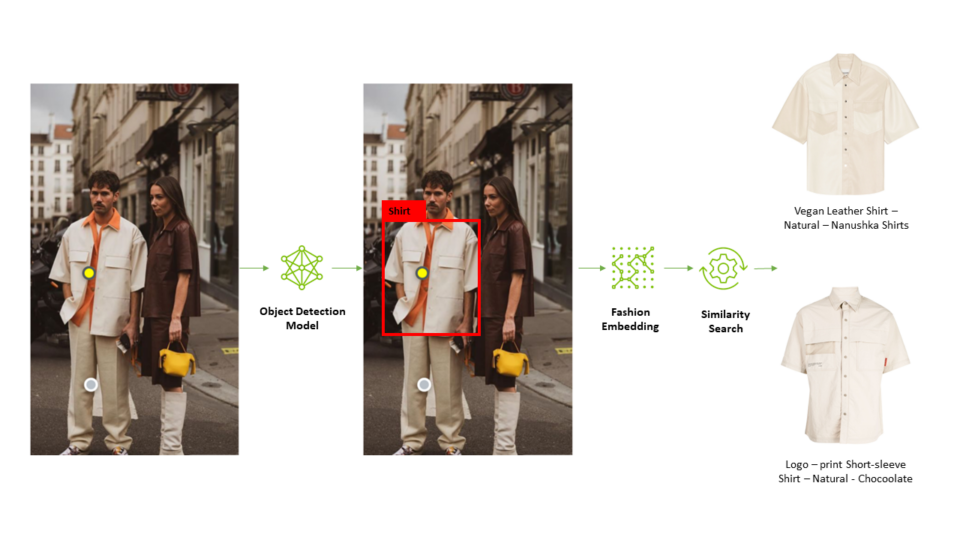

Verbesserung kreativer Workflows mit Let’s Enhance

KI-gestützte Bildgenerierung hat kreative Workflows transformiert und kann auf Unternehmensanwendungen wie das Erstellen von personalisierten Inhalten und fantasievollen Hintergründen für Marketingbilder genutzt werden. Diffusion-Modelle sind zwar leistungsstarke Tools zur Verbesserung kreativer Workflows, können jedoch enorm rechenintensiv sein.

Um seine Workflows mit dem Modell Stable Diffusion XL in der Produktion zu optimieren, entschied sich Let’s Enhance, ein zukunftsweisendes KI-Startup, für die NVIDIA AI-Inferenzplattform.

Das neueste Produkt von Let’s Enhance, AI Photoshoot, nutzt das SDXL-Modell, um einfache Produktfotos in ansprechende visuelle Assets für E-Commerce-Websites und Marketingkampagnen zu verwandeln.

Mit der zuverlässigen Unterstützung von NVIDIA Triton für verschiedene Frameworks und Backends in Verbindung mit dem dynamischen Batch-Funktionssatz war Let’s Enhance in der Lage, das SDXL-Modell mit minimaler Beteiligung von Ingenieurteams nahtlos in vorhandene KI-Pipelines zu integrieren. So blieb den Ingenieuren mehr Zeit für Forschung und Entwicklung.

Beschleunigung von Cloud-basierter Vision-KI mit OCI

Oracle Cloud Infrastructure (OCI) hat NVIDIA Triton in seinen Vision-KI-Dienst integriert, um den Vorhersagedurchsatz um bis zu 76 % zu erhöhen und die Latenz um 51 % zu reduzieren. So konnte die Kundenerfahrung bei verschiedenen Anwendungen verbessert werden. Dazu gehörten die Automatisierung der Mautabrechnung in Transitunternehmen und die Vereinfachung der Rechnungserkennung in globalen Unternehmen.

Mit den hardwareunabhängigen Funktionen von Triton hat OCI sein Portfolio an KI-Diensten erweitert und stellt in seinen globalen Rechenzentren robuste und effiziente Lösungen zur Verfügung.

„Unsere KI-Plattform ist zum Nutzen unserer Kunden Triton-fähig“, so Tzvi Keisar, Leiter des Produktmanagements für den Datenwissenschaftsdienst von OCI, der für interne und externe Benutzer von Oracle das maschinelle Lernen übernimmt.

Kontextbasierte Intelligenz in Echtzeit und Sucheffizienz mit Microsoft

Azure bietet eine der umfangreichsten und breitesten Angebotspaletten an virtuellen Maschinen, die von NVIDIA AI unterstützt und optimiert werden. Diese virtuellen Maschinen umfassen mehrere Generationen von NVIDIA-GPUs, einschließlich NVIDIA Blackwell- und NVIDIA Hopper-Systemen.

Aufbauend auf dieser intensiven Geschichte der Zusammenarbeit im Ingenieurwesen helfen NVIDIA-GPUs und NVIDIA Triton jetzt dabei, in Copilot für Microsoft 365 KI-Inferenzaufgaben zu beschleunigen. Microsoft 365 Copilot ist bei Windows-PCs als eigene physische Taste verfügbar und verbindet die Leistung von LLMs mit proprietären Unternehmensdaten, um kontextbasierte Echtzeit-Informationen zu liefern, die es Benutzern erlauben, ihre Kreativität, Produktivität und Fähigkeiten zu verbessern.

Außerdem griff Microsoft Bing auf NVIDIA-Inferenzlösungen zurück, um Herausforderungen wie Latenz, Kosten und Geschwindigkeit zu bewältigen. Durch die Integration von NVIDIA TensorRT-LLM-Verfahren konnte Microsoft die Inferenzleistung bei seiner Deep Search-Funktion erheblich verbessern, was für optimierte Webergebnisse sorgt.

Schritt-für-Schritt-Anleitung für Deep Search mit freundlicher Genehmigung von Microsoft

Mit der visuellen Suche von Microsoft Bing können Menschen auf der ganzen Welt Inhalte finden, indem sie Fotos als Abfragen verwenden. Das Herzstück dieser Funktion ist das Visual-Embedding-Modell TuringMM von Microsoft, das Bilder und Text in einem gemeinsamen hochdimensionalen Raum abbildet. Da das Modell mit Milliarden von Bildern im gesamten Web arbeitet, ist hohe Leistung sehr wichtig.

Microsoft Bing hat die TuringMM-Pipeline mit NVIDIA TensorRT und NVIDIA-Beschleunigungsbibliotheken (einschließlich CV-CUDA und nvImageCodec) optimiert. Diese Maßnahmen haben zu einer 5,13-fachen Beschleunigung und einer erheblichen Reduzierung der TCO geführt.

Mit Hardwareinnovationen das volle Potenzial von KI-Inferenz nutzen

Die Verbesserung der Effizienz von KI-Inferenz-Workloads ist eine vielschichtige Herausforderung, die über Hardware und Software hinweg innovative Technologien erfordert.

NVIDIA-GPUs stehen an der Spitze der KI-Unterstützung und bieten extrem hohe Effizienz und Leistung für KI-Modelle. Sie sind zudem führend, was hohe Energieeffizienz angeht: NVIDIA-beschleunigtes Computing in der NVIDIA Blackwell-Architektur hat den Energieverbrauch pro generiertem Token in den letzten zehn Jahren bei der Inferenz von KI-Modellen mit Billionen Parametern um das Hunderttausendfache reduziert.

Der NVIDIA Grace Hopper Superchip, der NVIDIA Grace CPU- und Hopper GPU-Architekturen mit NVIDIA NVLink-C2C kombiniert, sorgt in verschiedenen Branchen für signifikante Verbesserungen der Inferenzleistung.

Optimierung des Werbepotenzials mit branchenführendem Maschinellen Lernen (ML) von Meta Andromeda

Meta Andromeda nutzt den Superchip für ein effizientes und leistungsstarkes Abrufen von personalisierten Anzeigen. Durch die Einrichtung tiefer neuronaler Netzwerke mit erhöhter Rechenkomplexität und Parallelität wurde bei Facebook und Instagram eine Steigerung der Anzeigenqualität in ausgewählten Segmenten um 8 % und eine Verbesserung der Abrufe um 6 % erreicht.

Durch optimierte Abrufmodelle und Memory-IO-sensible GPU-Operatoren mit niedriger Latenz und hohem Durchsatz sorgt Andromeda für eine 100 Mal schnellere Funktionsextraktion im Vergleich zu früheren CPU-basierten Komponenten. Diese Integration von KI in der Abrufphase hat es Meta ermöglicht, die branchenweite Führung im Bereich von Anzeigenabrufen zu übernehmen, indem für ein besseres Benutzererlebnis und mehr Rentabilität der Werbeausgaben Herausforderungen wie Skalierbarkeit und Latenz angegangen wurden.

Da fortgeschrittene KI-Modelle immer größer werden, steigt auch die Rechenleistung, die für das Generieren der einzelnen Token erforderlich ist. Um hochmoderne LLMs in Echtzeit ausführen zu können, brauchen Unternehmen mehrere GPUs, die zusammenarbeiten. Tools wie die NVIDIA Collective Communication Library (NCCL) ermöglichen es Systemen mit mehreren GPUs, große Datenmengen zwischen GPUs in minimaler Zeit auszutauschen.

Zukünftige Innovationen im Bereich KI-Inferenz

Die Zukunft der KI-Inferenz verspricht erhebliche Fortschritte bei Leistung und Kosten.

Die Kombination aus NVIDIA-Software, neuartigen Techniken und fortschrittlicher Hardware erlaubt es Rechenzentren, immer komplexere und vielfältigere Workloads zu bewältigen. KI-Inferenz wird Fortschritte in Branchen wie dem Gesundheits- und dem Finanzwesen weiter fördern, indem sie genauere Vorhersagen, eine schnellere Entscheidungsfindung und bessere Benutzererlebnisse ermöglicht.

Da sich diese Trends weiterentwickeln, ist es wichtig, dass Unternehmen auf dem Laufenden bleiben und die neuesten Inferenzoptimierungen nutzen, um Investitionen zu maximieren und im Zeitalter der KI wettbewerbsfähig zu bleiben.

Erfahren Sie mehr darüber, wie NVIDIA für bahnbrechende Ergebnisse bei der Inferenzleistung sorgt, und bleiben Sie mit den neuesten Updates für KI-Inferenzleistung auf dem aktuellen Stand der Technik.