Seit ihrer Einführung hat die NVIDIA Hopper-Architektur die KI- und High-Performance-Computing-Landschaft (HPC) verändert und hilft Unternehmen, Forschern und Entwicklern, die komplexesten Herausforderungen der Welt mit höherer Leistung und größerer Energieeffizienz zu bewältigen.

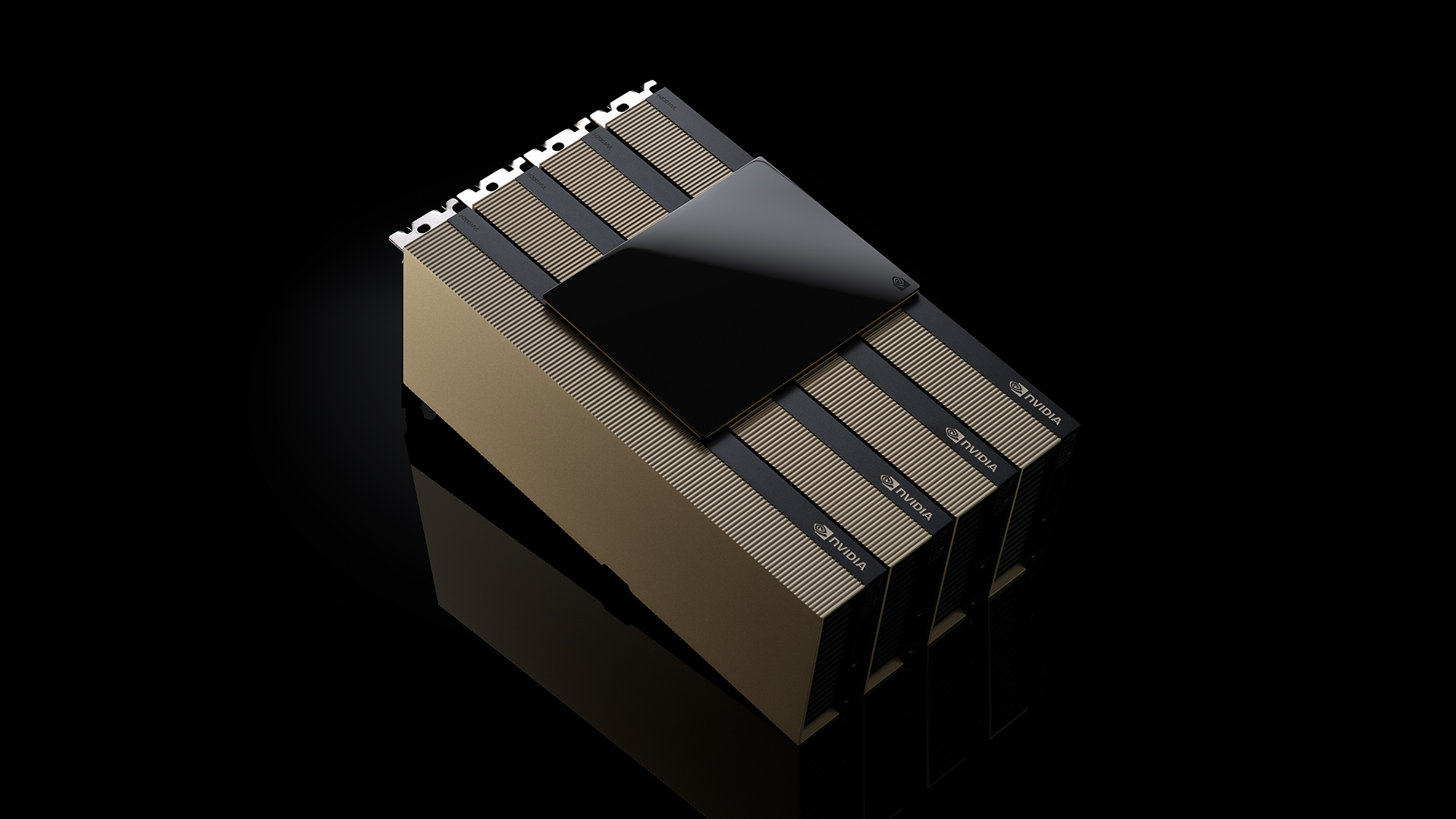

Während der Konferenz Supercomputing 2024 kündigte NVIDIA die Verfügbarkeit des NVIDIA H200 NVL PCIe-GPU an – das neueste Mitglied der Hopper-Familie. H200 NVL ist ideal für Unternehmen mit Rechenzentren, die ein luftgekühltes Enterprise-Rack-Design mit reduzierter Energie und flexiblen Konfigurationen zur Beschleunigung aller KI- und HPC-Workloads suchen, unabhängig von der Größe.

Einer kürzlich durchgeführten Umfrage zufolge sind etwa 70 % der Racks in Unternehmen mit 20 kW und weniger ausgestattet und werden mit Luft gekühlt. Dies macht PCIe-GPUs unverzichtbar, da sie die Granularität der Knotenbereitstellung ermöglichen, egal ob ein, zwei, vier oder acht GPUs verwendet werden. So können Rechenzentren mehr Rechenleistung auf kleinerem Raum unterbringen. Unternehmen können dann ihre bestehenden Racks nutzen und die Anzahl der GPUs auswählen, die Ihren Anforderungen am besten entspricht.

Unternehmen können H200 NVL nutzen, um KI- und HPC-Anwendungen zu beschleunigen und gleichzeitig die Energieeffizienz durch einen reduzierten Stromverbrauch zu verbessern. Mit einem 1,5-fachen Speicherzuwachs und einer 1,2-fachen Bandbreitensteigerung gegenüber NVIDIA H100 NVL können Unternehmen mit H200 NVL LLMs innerhalb weniger Stunden feinabstimmen und eine bis zu 1,7-fach schnellere Inferenzleistung erzielen. Bei HPC-Workloads wird die Leistung im Vergleich zu H100 NVL um das bis zu 1,3-fache und im Vergleich zu der NVIDIA Ampere Architekturgeneration um das 2,5-fache gesteigert.

Ergänzt wird die Rohleistung des H200 NVL durch die NVIDIA NVLink-Technologie. Die neueste Generation von NVLink ermöglicht eine 7-mal schnellere GPU-zu-GPU-Kommunikation als PCIe der fünften Generation und bietet damit eine höhere Leistung, die den Anforderungen von HPC, Inferenz großer Sprachmodelle und Feinabstimmung gerecht wird.

Der NVIDIA H200 NVL ist mit leistungsstarken Software-Tools gekoppelt, mit denen Unternehmen Anwendungen von KI bis HPC beschleunigen können. Im Lieferumfang enthalten ist ein Fünf-Jahres-Abonnement für NVIDIA AI Enterprise, eine Cloud-native Software-Plattform für die Entwicklung und Bereitstellung von KI im Produktionsbetrieb. NVIDIA AI Enterprise umfasst NVIDIA NIM-Microservices für die sichere, zuverlässige Bereitstellung einer leistungsstarken KI-Modellinferenz.

Unternehmen nutzen die Leistung von H200 NVL

Mit H200 NVL bietet NVIDIA Unternehmen eine Full-Stack-Plattform für die Entwicklung und Bereitstellung ihrer KI- und HPC-Workloads.

Die Kunden sehen signifikante Auswirkungen für verschiedene KI- und HPC-Anwendungsfälle in verschiedenen Branchen, wie z. B. visuelle KI-Agenten und Chatbots für den Kundenservice, Handelsalgorithmen für das Finanzwesen, medizinische Bildgebung für eine verbesserte Erkennung von Anomalien im Gesundheitswesen, Mustererkennung für die Fertigung und seismische Bildgebung für staatliche Wissenschaftsorganisationen.

Dropbox nutzt beschleunigtes Computing von NVIDIA für seine Dienste und seine Infrastruktur.

„Dropbox verarbeitet große Mengen an Inhalten, die fortschrittliche KI- und maschinelle Lernfunktionen erfordern“, so Ali Zafar, VP of Infrastructure bei Dropbox. „Wir erkunden H200 NVL, um unsere Dienste kontinuierlich zu verbessern und unseren Kunden einen größeren Mehrwert zu bieten.“

Die University of New Mexico nutzt beschleunigtes Computing von NVIDIA in verschiedenen Forschungs- und akademischen Anwendungen.

„Als öffentliche Forschungsuniversität ermöglicht unser Engagement für KI der Universität, an der Spitze des wissenschaftlichen und technologischen Fortschritts zu stehen“, sagte Prof. Patrick Bridges, Direktor des UNM Center for Advanced Research Computing. „Mit der Umstellung auf H200 NVL können wir eine Vielzahl von Anwendungen beschleunigen, darunter Data-Science-Initiativen, Bioinformatik und Genomforschung, Physik- und Astronomiesimulationen, Klimamodellierung und mehr.“

H200 NVL im gesamten Ökosystem verfügbar

Dell Technologies, Hewlett Packard Enterprise, Lenovo und Supermicro werden voraussichtlich eine breite Palette von Konfigurationen anbieten, die H200 NVL unterstützen.

Zusätzlich wird die H200 NVL in Plattformen von Aivres, ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, MSI, Pegatron, QCT, Wistron und Wiwynn verfügbar sein.

Einige Systeme basieren auf der modularen Architektur von NVIDIA MGX, die es Computerherstellern ermöglicht, schnell und kosteneffizient eine breite Palette von Infrastrukturdesigns für Rechenzentren zu erstellen.

Plattformen mit H200 NVL werden ab Dezember bei den globalen Systempartnern von NVIDIA erhältlich sein. Als Ergänzung zur Verfügbarkeit durch führende globale Partner entwickelt NVIDIA außerdem eine Enterprise-Referenzarchitektur für H200 NVL-Systeme.

In die Referenzarchitektur fließen das Know-how und die Designprinzipien von NVIDIA ein, sodass Partner und Kunden eine hochleistungsfähige KI-Infrastruktur auf der Grundlage von H200 NVL in großem Umfang entwickeln und bereitstellen können. Dies umfasst Full-Stack-Hardware- und Software-Empfehlungen mit detaillierten Anleitungen für optimale Server-, Cluster- und Netzwerkkonfigurationen. Das Netzwerk ist mit der NVIDIA Spectrum-X Ethernet-Plattform für höchste Leistung optimiert.

Siehe Hinweis zu Software-Produktinformationen.