Die beschleunigte Computing-Plattform von NVIDIA ist führend in Supercomputing-Benchmarks, die einst von CPUs dominiert wurden, und ermöglicht weltweit effiziente KI, Wissenschaft, Wirtschaft und Rechenleistung.

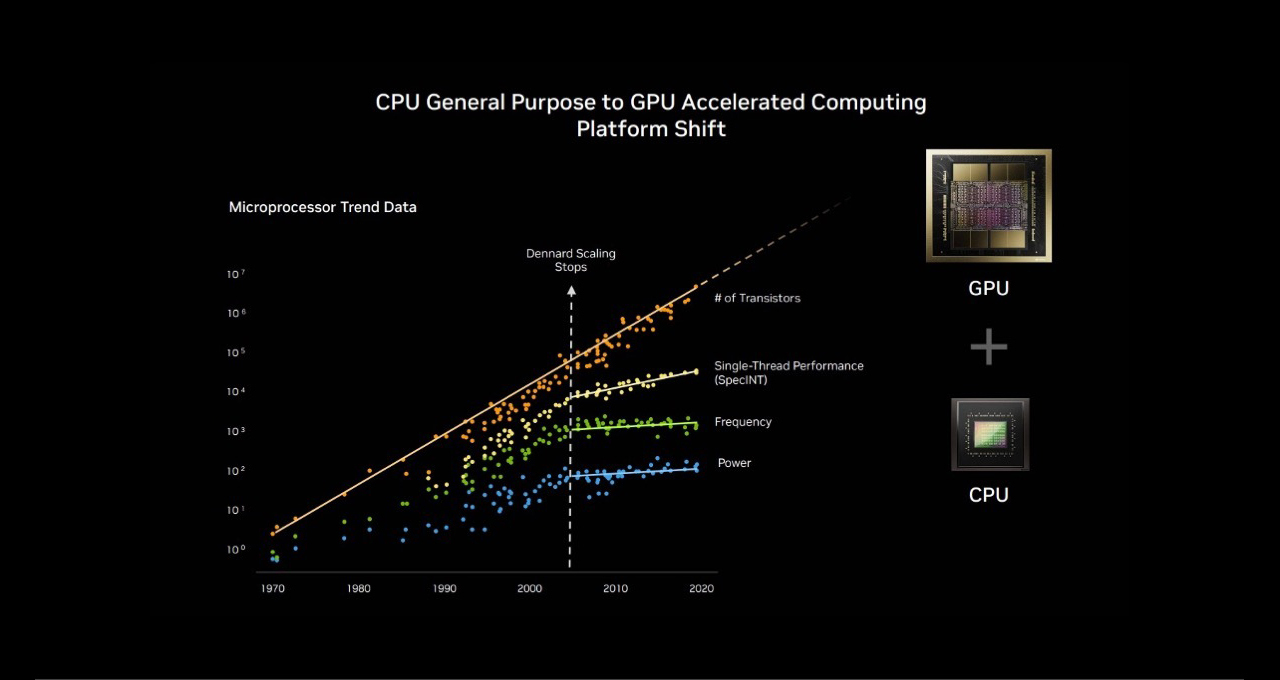

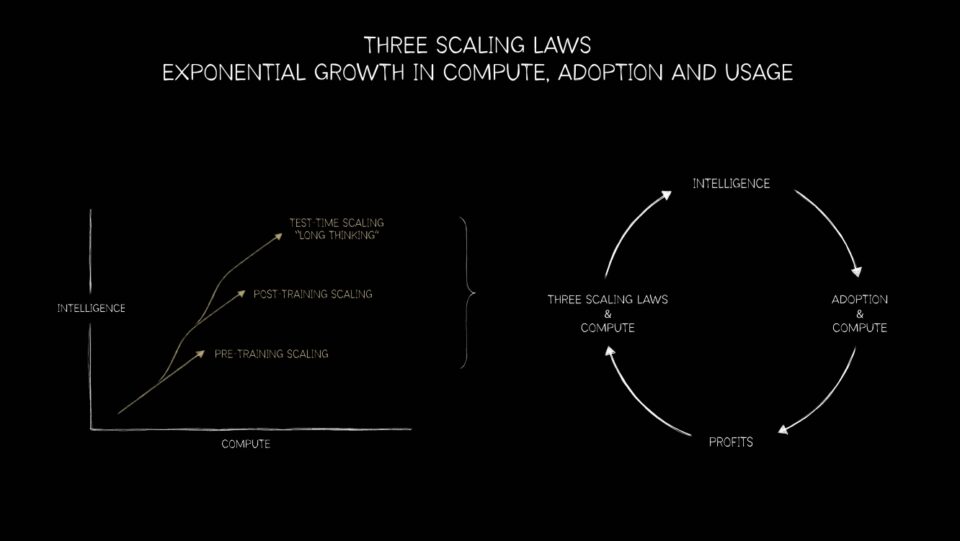

Das Mooresche Gesetz hat seine Gültigkeit erschöpft und die parallele Verarbeitung ist der Weg in die Zukunft. Dank dieser Entwicklung sind NVIDIA GPU-Plattformen jetzt in der einzigartigen Position und können die drei Skalierungsgesetze – Pre-Training, Nachtrainieren und Berechnung in der Testzeit – für alle Bereiche, von Empfehlungssystemen der nächsten Generation und großen Sprachmodellen (LLMs) bis hin zu KI-Agenten und darüber hinaus.

- Wie NVIDIA die Grundlagen des Computings transformiert hat

- KI-Pre-Training, Nachtrainieren und Inferenz treiben die Grenzen voran

- Wie Hyperscaler KI nutzen, um Such- und Empfehlungssysteme zu transformieren

Der Übergang von CPU zu GPU: Eine historische Veränderung im Computing 🔗

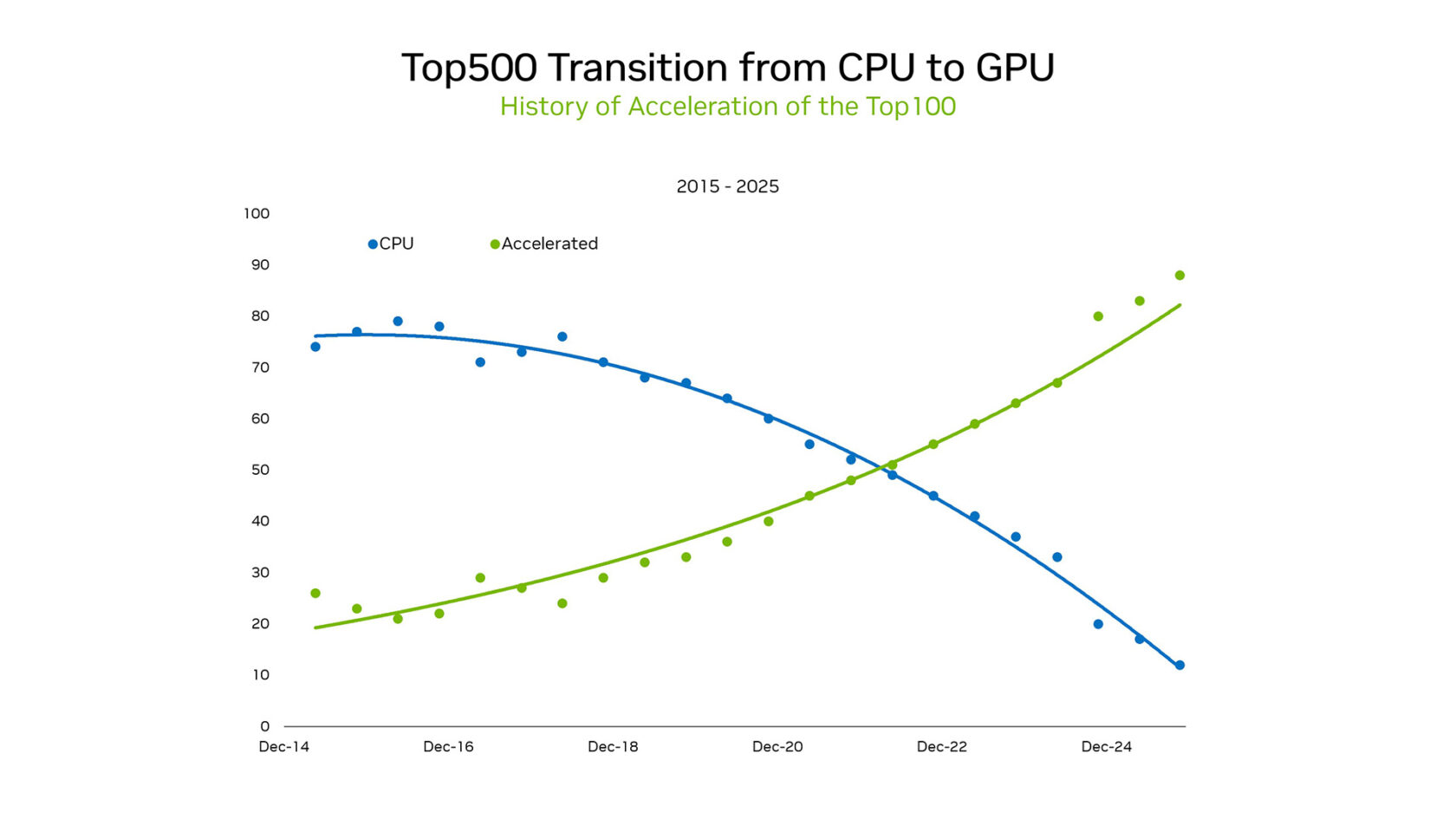

Auf der SC25 hat NVIDIA-Gründer und CEO Jensen Huang die sich verändernde Lage hervorgehoben. Innerhalb der TOP100, einer Teilmenge der TOP500-Liste der Supercomputer, verwenden über 85 % der Systeme GPUs. Diese Umstellung stellt einen historischen Übergang vom seriellen Verarbeitungsparadigma von CPUs zu massiv parallelen beschleunigten Architekturen dar.

Vor 2012 basierte maschinelles Lernen auf programmierter Logik. Es wurden statistische Modelle verwendet, die als fest codierte Regeln auf CPUs effizient ausgeführt wurden. Das änderte sich jedoch, als AlexNet auf Gaming-GPUs zeigte, dass die Bildklassifizierung anhand von Beispielen gelernt werden kann. Die Auswirkungen auf die Zukunft der KI waren enorm, und die parallele Verarbeitung immer größerer Datenmengen auf GPUs trieb eine neue Welle des Computing voran.

Bei dieser Umkehr geht es nicht nur um die Hardware. Es geht um Plattformen, die neue Wissenschaft erschließen. GPUs bieten deutlich mehr Rechenoperationen pro Watt, was Exascale ohne unhaltbaren Energiebedarf möglich macht.

Die jüngsten Ergebnisse der Green500, einem Ranking der energieeffizientesten Supercomputer der Welt, unterstreichen den Kontrast zwischen GPUs und CPUs. Die fünf besten Ergebnisse dieses Branchen-Benchmarks erzielten alle NVIDIA-GPUs, die im Durchschnitt 70,1 Gigaflops pro Watt lieferten. Die besten reinen CPU-Systeme lieferten hingegen im Durchschnitt 15,5 Flops pro Watt. Dieser 4,5-fache Unterschied zwischen GPUs und CPUs in Bezug auf die Energieeffizienz zeigt den enormen Vorteil der Umstellung dieser Systeme auf GPUs bei den Gesamtbetriebskosten (TCO).

Die Ergebnisse von NVIDIA für Graph500 zeigten eine weitere Messung der Energieeffizienz und des Leistungsunterschiedes zwischen CPU und GPU. NVIDIA lieferte mit 410 Billionen durchquerten Kanten pro Sekunde ein Rekordergebnis und platzierte sich damit auf der Graph500-Breitensuchliste an erster Stelle.

Der Sieger hat die nächsthöchste Punktzahl mehr als verdoppelt und mit 8.192 NVIDIA H100-GPUs einen Graphen mit 2,2 Billionen Scheitelpunkten und 35 Billionen Kanten verarbeitet. Das steht im Vergleich zum nächstbesten Ergebnis auf der Liste, für das für diesen Workload rund 150.000 CPUs erforderlich waren. Reduzierungen des Hardware-Platzbedarfs in dieser Größenordnung sparen Zeit, Geld und Energie.

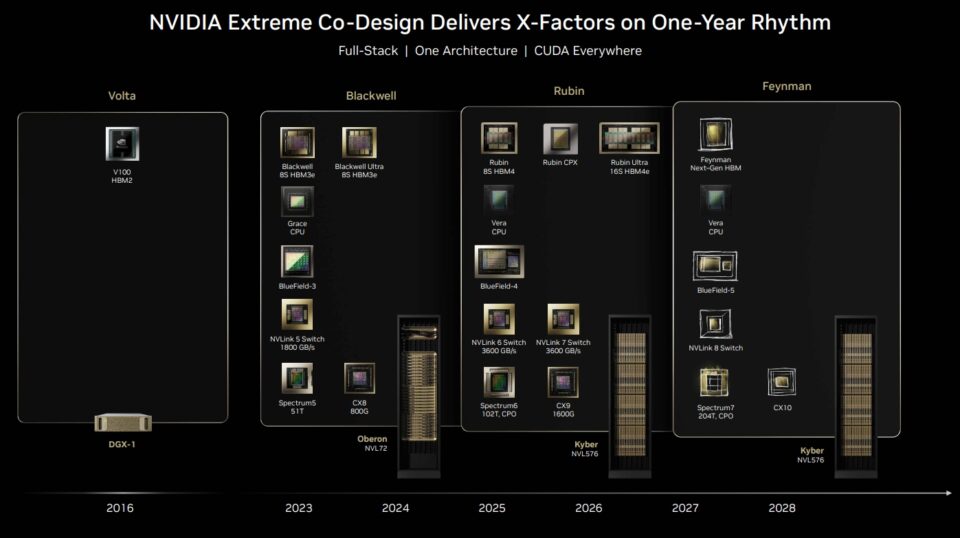

Doch NVIDIA hat auf der SC25 gezeigt, dass seine KI-Supercomputing-Plattform weit mehr als GPUs bietet. Netzwerk, CUDA-Bibliotheken, Speicher, Datenspeicher und Orchestrierung wurden gemeinsam für eine Full-Stack-Plattform entwickelt.

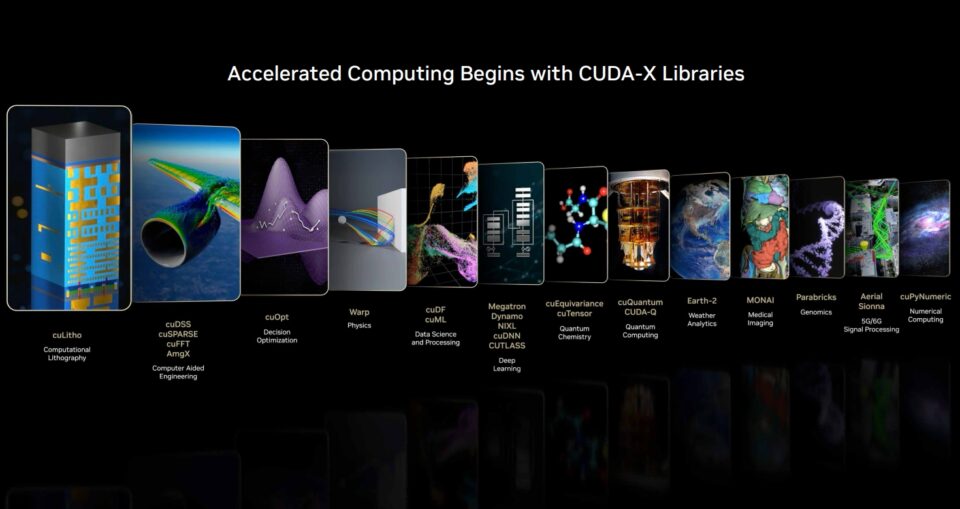

NVIDIA ist eine Full-Stack-Plattform, die durch CUDA ermöglicht wird. Open-Source-Bibliotheken und Frameworks, wie sie im CUDA-X-Ökosystem verfügbar sind, sind die wichtigsten Faktoren, die große Geschwindigkeitssteigerungen ermöglichen. Snowflake hat vor kurzem die Integration von NVIDIA A10-GPUs angekündigt, um Datenwissenschafts-Workflows zu optimieren. Snowflake ML ist jetzt mit den NVIDIA cuML– und cuDF-Bibliotheken vorinstalliert, um beliebte ML-Algorithmen mithilfe von GPUs zu beschleunigen.

Mit dieser nativen Integration können Benutzer von Snowflake Modellentwicklungszyklen ganz einfach beschleunigen, ohne dass Codeänderungen erforderlich sind. Die Benchmark-Durchläufe von NVIDIA zeigen, dass Random Forest 5-mal weniger Zeit benötigt und HDBSCAN auf NVIDIA A10-GPUs bis zu 200-mal schneller als auf CPUs ausgeführt wird.

Der Wendepunkt war der Moment, in dem sich die Situation umkehrte. Die Skalierungsgesetze sind jetzt der Wegweiser. Und in jeder Phase sind GPUs der Motor, der die KI in die nächste Phase bringt.

Aber in CUDA-X und vielen Open-Source-Softwarebibliotheken und Frameworks findet der Großteil der Magie statt. CUDA-X-Bibliotheken beschleunigen Workloads in allen Branchen und Anwendungen – Ingenieurwesen, Finanzen, Datenanalyse, Genomik, Biologie, Chemie, Telekommunikation, Robotik und vielen mehr.

„Weltweit wird viel in Nicht-KI-Software investiert. Von der Datenverarbeitung über wissenschaftliche und technische Simulationen bis hin zu Cloud-Computing-Ausgaben in Höhe von Hunderten Milliarden Dollar pro Jahr“, erklärte Huang kürzlich bei der Bekanntgabe der Geschäftszahlen von NVIDIA.

Viele Anwendungen, die früher ausschließlich auf CPUs ausgeführt wurden, werden nun schnell auf CUDA-GPUs umgestellt. „Beschleunigtes Computing hat einen Wendepunkt erreicht. Die KI hat einen entscheidenden Punkt erreicht und transformiert bestehende Anwendungen und ermöglicht gleichzeitig völlig neue Anwendungen“, erklärt er.

Was als Gebot für Energieeffizienz begann, hat sich zu einer wissenschaftlichen Plattform entwickelt: Simulation und KI im großen Maßstab verschmelzen. Die führende Position von NVIDIA-GPUs unter den TOP100 ist sowohl ein Beweis für diese Entwicklung als auch ein Signal für das, was als Nächstes kommt: Durchbrüche in allen Disziplinen.

Dadurch können Forscher jetzt Modelle mit Billiarden Parametern trainieren, Fusionsreaktoren simulieren und die Medikamentenentwicklung in einem Maßstab beschleunigen, den CPUs allein nicht erreichen könnten.

Die drei Skalierungsgesetze, die die nächste Grenze der KI vorantreiben 🔗

Der Wechsel von CPUs zu GPUs ist nicht nur ein Meilenstein im Supercomputing. Es ist die Grundlage für die drei Skalierungsgesetze, die die Roadmap für den nächsten Workflow in der KI darstellen: Pre-Training, Post-Training und Testzeit-Skalierung.

Pre-Training-Skalierung war das erste Gesetz, das die Branche unterstützt hat. Die Forscher fanden heraus, dass sich die Modellleistung mit zunehmenden Datensätzen, der Parameteranzahl und der Rechenleistung vorhersehbar verbesserte. Die Verdoppelung der Daten oder Parameter führte zu Fortschritten in der Genauigkeit und Vielseitigkeit.

Bei den neuesten MLPerf Training-Benchmarks zeigte die NVIDIA-Plattform bei jedem Test die höchste Leistung und war die einzige Plattform, die alle Tests absolvierte. Ohne GPUs wäre die Ära der KI-Forschung nach dem Motto „größer ist besser“ unter der Last von Energiebudgets und Zeitbeschränkungen ins Stocken geraten.

Die Skalierung nach dem Training erweitert die Geschichte. Sobald ein Foundation Model entwickelt ist, muss es verfeinert werden – abgestimmt auf Branchen, Sprachen oder Sicherheitseinschränkungen. Techniken wie bestärkendes Lernen durch menschliches Feedback, Beschneiden und Destillieren erfordern eine enorme zusätzliche Rechenleistung. In einigen Fällen können die Anforderungen mit dem Vortraining selbst konkurrieren. Es ist so, als würde sich ein Schüler nach der Grundschule verbessern. GPUs stellen erneut die Leistung bereit und ermöglichen eine kontinuierliche Feinabstimmung und Anpassung in verschiedenen Bereichen.

Die Skalierung in der Testzeit, das neueste Gesetz, könnte sich als die transformativste Entwicklung erweisen. Moderne Modelle, die auf Mixture-of-Experts-Architekturen basieren, können mehrere Lösungen in Echtzeit analysieren, planen und bewerten. Chain‑of‑thought reasoning, generative Suche und agentische KI erfordern dynamische, rekursive Rechenleistung und übertreffen die Anforderungen an das Pretraining oftmals deutlich. Diese Phase wird die Nachfrage nach Inferenzinfrastruktur exponentiell steigern – von Rechenzentren bis hin zu Edge-Geräten.

Zusammen verdeutlichen diese drei Gesetze die Nachfrage nach GPUs für neue KI-Workloads. Die Pre-Training-Skalierung hat GPUs unverzichtbar gemacht. Die Skalierung nach dem Training hat ihre Rolle bei der Verfeinerung gestärkt. Die Skalierung in der Testzeit stellt sicher, dass GPUs auch nach Ende des Trainings entscheidend bleiben. Dies ist das nächste Kapitel in der Welt des beschleunigten Computings: Ein Lebenszyklus, in dem GPUs jede Phase der KI vorantreiben – vom Lernen über logisches Denken bis hin zur Bereitstellung.

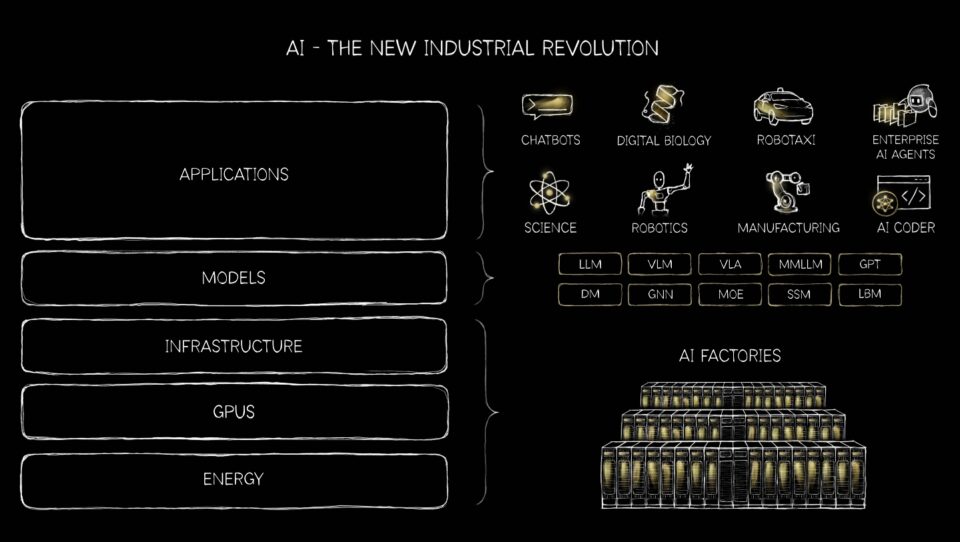

Generative, agentische, physische KI und darüber hinaus 🔗

Die Welt der KI geht weit über einfache Empfehlungen, Chatbots und die Textgenerierung hinaus. VLMs oder visuelle Sprachmodelle sind KI-Systeme, die Computer Vision und die Verarbeitung natürlicher Sprache kombinieren, um Bilder und Text zu verstehen und zu interpretieren. Empfehlungssysteme – die Motoren hinter personalisiertem Einkaufen, Streaming und sozialen Feeds – sind nur eines von vielen Beispielen dafür, wie der umfassende Übergang von CPUs auf GPUs die KI neu gestaltet.

Generative KI verändert unterdessen alles von der Robotik und autonomen Fahrzeugen bis hin zu Software-as-a-Service-Unternehmen und stellt eine enorme Investition in Startups dar.

NVIDIA-Plattformen sind die einzigen, die auf allen führenden generativen KI-Modellen ausgeführt werden können und 1,4 Millionen Open-Source-Modelle verarbeiten können.

Früher waren Empfehlungssysteme durch CPU-Architekturen eingeschränkt und hatten Schwierigkeiten, die Komplexität des Benutzerverhaltens in großem Maßstab zu erfassen. Mit CUDA-GPUs können Modelle durch die Pre-Training-Skalierung aus umfangreichen Datensätzen von Klicks, Käufen und Präferenzen lernen und so ausführlichere Muster erkennen. Die Skalierung nach dem Training passt diese Modelle für bestimmte Bereiche an und verbessert die Personalisierung für Branchen vom Einzelhandel bis hin zur Unterhaltungsbranche. Auf führenden globalen Websiten kann selbst eine Steigerung der Relevanz von Empfehlungen um 1 % weitere Milliarden an Umsätzen generieren.

Laut Emarketer wird der Umsatz im elektronischen Handel bis 2025 weltweit 6,4 Billionen US-Dollar erreichen.

Die weltweit führenden Hyperscaler, eine Billionen-Dollar-Branche, transformieren die Suche, Empfehlungen und das Verständnis von Inhalten vom klassischen maschinellen Lernen hin zu generativer KI. NVIDIA CUDA zeichnet sich in beiden Bereichen aus und ist die ideale Plattform für diesen Übergang, der Investitionen in die Infrastruktur von mehreren hundert Milliarden Dollar vorantreibt.

Die Skalierung in der Testzeit verändert nun die Inferenz selbst: Empfehlungs-Engines können dynamisch denken, mehrere Optionen in Echtzeit bewerten und kontextbezogene Vorschläge liefern. Das Ergebnis ist ein Sprung in Präzision und Relevanz – Empfehlungen, die sich weniger wie statische Listen anfühlen, sondern eher wie intelligente Anleitung. GPUs und Skalierungsgesetze machen Empfehlungen von einer Hintergrundfunktion zu einer zentralen Fähigkeit der agentischen KI, die es Milliarden von Menschen ermöglicht, Billionen von Dingen im Internet mit einer Leichtigkeit zu sortieren, die sonst nicht möglich wäre.

Was als Gesprächsschnittstellen, die von LLMs unterstützt werden, begann, entwickelt sich jetzt zu intelligenten, autonomen Systemen, die nahezu alle Bereiche der Weltwirtschaft neu gestalten werden.

Wir erleben eine grundlegende Veränderung – von KI als virtueller Technologie hin zu einer Technologie, die in die physische Welt eintritt. Diese Transformation erfordert nichts weniger als ein explosives Wachstum der Recheninfrastruktur und neue Formen der Zusammenarbeit zwischen Mensch und Maschine.

Generative KI hat sich als in der Lage erwiesen, nicht nur neue Texte und Bilder zu erstellen, sondern auch Code, Designs und sogar wissenschaftliche Hypothesen. Jetzt kommt die agentische KI – Systeme, die autonom wahrnehmen, schlussfolgern, planen und handeln. Diese KI-Agenten verhalten sich weniger wie Werkzeuge und mehr wie digitale Kollegen und führen komplexe, mehrstufige Aufgaben in verschiedenen Branchen aus. Von der Rechtsforschung bis hin zur Logistik verspricht agentische KI, die Produktivität zu beschleunigen, indem sie als autonome digitale Arbeitskräfte dient.

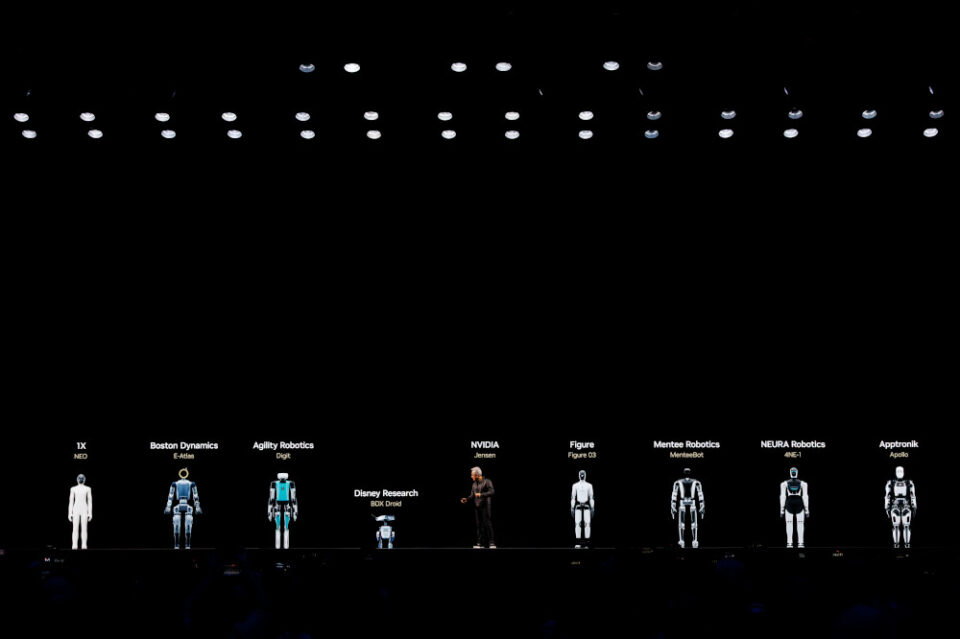

Der vielleicht größte Wandel ist physische KI – die Verkörperung von Intelligenz in Robotern jeder Form. Drei Computer sind erforderlich, um physische Roboter mit KI zu entwickeln: NVIDIA DGX GB300, um das logische Aktionsmodell für visuelle Schlussfolgerungen zu trainieren, NVIDIA RTX PRO, um das Modell in einer virtuellen Welt, die auf Omniverse basiert, zu simulieren, zu testen und zu validieren, und Jetson Thor, um die Schlussfolgerungs-VLA in Echtzeit auszuführen.

Was als nächstes erwartet wird, ist ein Durchbruch für die Robotik, bei dem autonome mobile Roboter, kollaborative Roboter und Humanoide die Fertigung, die Logistik und das Gesundheitswesen revolutionieren werden. Morgan Stanley schätzt, dass es bis 2050 eine Milliarde humanoide Roboter mit einem Umsatz von 5 Billionen US-Dollar geben wird.

Das signalisiert, wie tief sich KI in die physische Wirtschaft einbetten wird. Und das ist nur ein kleiner Ausschnitt dessen, was noch vor uns liegt.

KI ist nicht mehr nur ein Werkzeug. Es leistet Arbeit und kann alle Märkte im Wert von 100 Billionen US-Dollar transformieren. Und ein positiver Kreislauf der KI ist angekommen, der das gesamte Rechenstapel grundlegend verändert und alle Computer auf neue Supercomputing-Plattformen umgestellt wurden, wodurch sich deutlich größere Möglichkeiten eröffnen.