ChatGPT markierte den Urknall für generative KI. Antworten können auf nahezu jede Abfrage generiert werden, was dazu beiträgt, digitale Aufgaben wie Content-Erstellung, Kundenservice, Softwareentwicklung und Geschäftsabläufe für Wissensarbeiter zu transformieren.

Physische KI, die Verkörperung künstlicher Intelligenz in Humanoiden, Fabriken und anderen Geräten in industriellen Systemen, wartet noch auf ihren Durchbruch.

Dies hat Branchen wie Transport und Mobilität, Fertigung, Logistik und Robotik gebremst. Das wird sich dank drei Computern, die fortschrittliches Training, Simulation und Inferenz kombinieren, aber bald ändern.

Der Aufstieg multimodaler, physischer KI

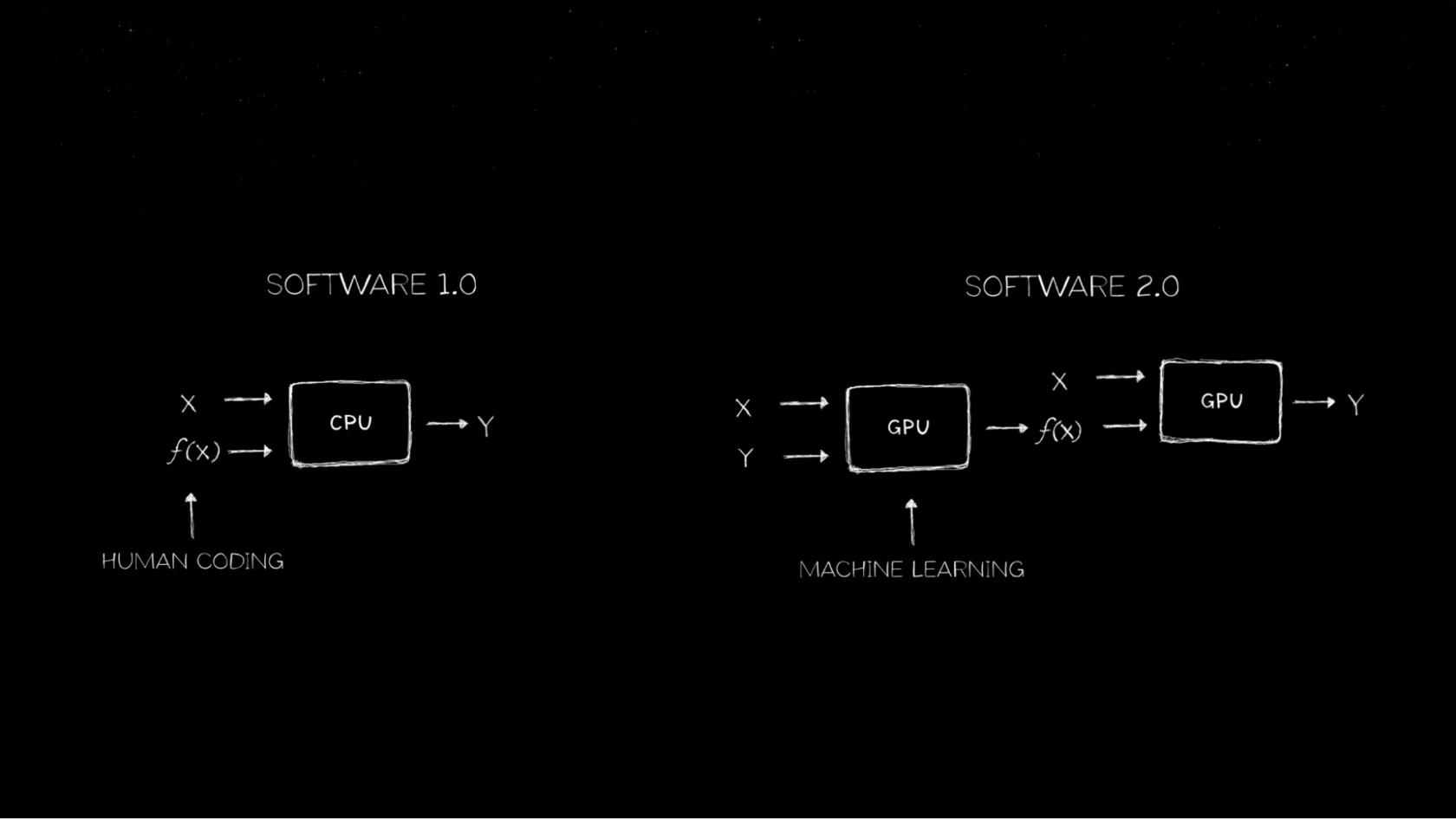

60 Jahre lang wurde „Software 1.0“ – serieller Code, der von menschlichen Programmierern geschrieben wurde – auf Allzweckcomputern, die von CPUs betrieben wurden, ausgeführt.

Im Jahr 2012 gewann dann Alex Krizhevsky, betreut von Ilya Sutskever und Geoffrey Hinton, den Wettbewerb für Computer-Bilderkennung von ImageNet mit AlexNet, einem revolutionären Deep-Learning-Modell für die Bildklassifizierung.

Dies war der erste Berührungspunkt der Branche mit KI. Der Durchbruch von maschinellem Lernen – neuronale Netzwerke, die auf GPUs ausgeführt werden – läutete die Ära von Software 2.0 ein.

Heute wird Software von Software geschrieben. Die Computing-Workloads der Welt verlagern sich von allgemeinen Computing-basierten CPUs zu beschleunigtem Computing auf GPUs, womit das Mooresche Gesetz hinter sich gelassen wird.

Mit generativer KI wurden multimodale Transformator- und Diffusionsmodelle auf das Generieren von Antworten trainiert.

Große Sprachmodelle sind eindimensional und in der Lage, das nächste Token in Modi wie Buchstaben oder Wörtern vorherzusagen. Modelle für die Bild- und Videogenerierung sind zweidimensional und können das nächste Pixel vorhersagen.

Keines dieser Modelle kann jedoch die dreidimensionale Welt verstehen oder interpretieren. Hier kommt physische KI ins Spiel.

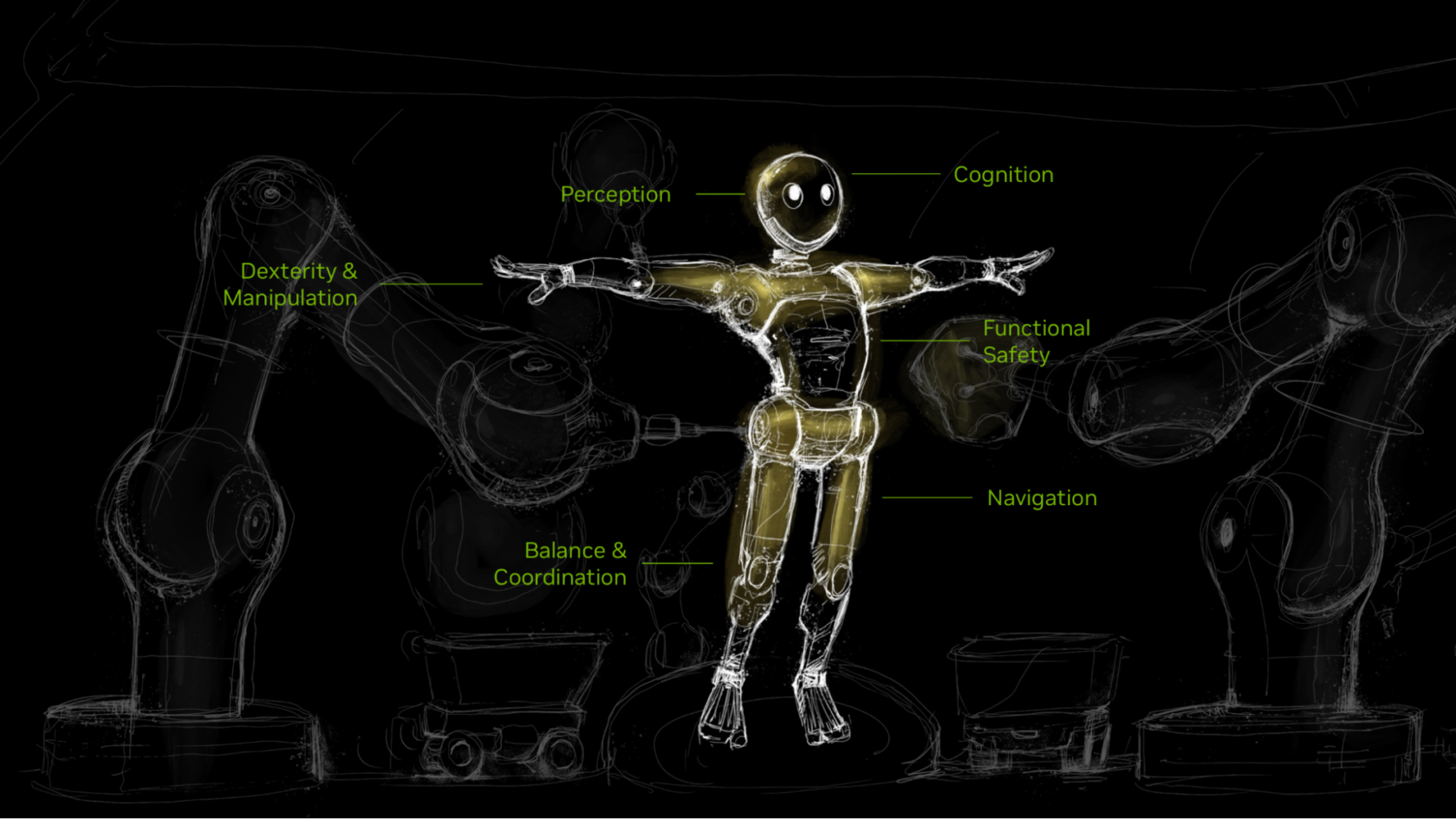

Physische KI-Modelle können die physische Welt mit generativer KI wahrnehmen, verstehen, navigieren und mit ihr interagieren. Durch beschleunigtes Computing können Durchbrüche bei multimodaler physischer KI und groß angelegte physikbasierte Simulationen der Welt den Wert physischer KI durch Roboter erschließen.

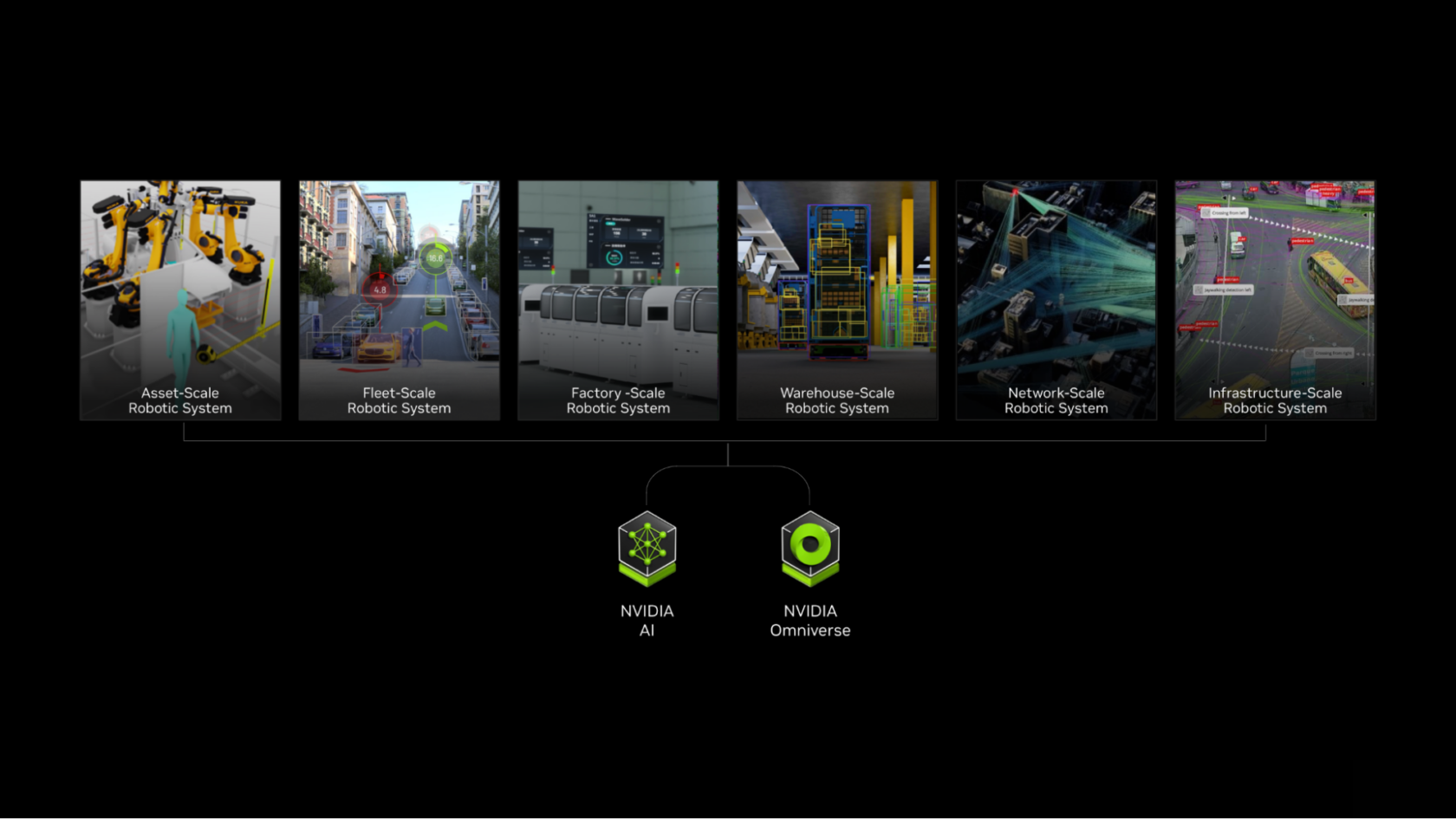

Ein Roboter ist ein System, das wahrnehmen, argumentieren, planen, handeln und lernen kann. Roboter werden oft als autonome mobile Roboter (AMRs), Manipulatorarme oder Humanoide betrachtet. Es gibt jedoch viele weitere Arten von Ausführungsformen.

In naher Zukunft werden alle Systeme, die sich bewegen oder Dinge überwachen, die sich bewegen, autonome Robotersysteme sein. Solche Systeme werden in der Lage sein, ihre Umgebungen zu erkennen und auf sie zu reagieren.

Von Operationssälen bis hin zu Rechenzentren, Lagerhäusern und Fabriken oder auch Verkehrsleitsystemen und ganzen intelligenten Städten wird sich alles von statischen, manuell bedienten Systemen in autonome, interaktive Systeme verwandeln, die von physischer KI verkörpert werden.

Die nächste Grenze: Humanoide Roboter

Humanoide Roboter sind eine ideale universelle Robotermanifestation, da sie in für Menschen entwickelten Umgebungen effizient arbeiten können und gleichzeitig minimale Anpassungen für Bereitstellung und Betrieb erfordern.

Der globale Markt für humanoide Roboter wird sich bis 2035 voraussichtlich auf 38 Milliarden US-Dollar belaufen, was laut Goldman Sachs einer mehr als sechsfachen Steigerung gegenüber den rund 6 Milliarden US-Dollar entspricht, die vor fast zwei Jahren für denselben Zeitraum prognostiziert wurden.

Forscher und Entwickler auf der ganzen Welt arbeiten fieberhaft daran, diese nächste Welle von Robotern zu entwickeln.

Drei Computer für die Entwicklung physischer KI

Für die Entwicklung humanoider Roboter sind drei beschleunigte Computersysteme erforderlich, um physische KI und Robotertraining, -simulation und -laufzeit zu verarbeiten. Zwei Fortschritte im Computing beschleunigen die Entwicklung von humanoiden Robotern: multimodale Foundation-Modelle sowie skalierbare, physikbasierte Simulationen von Robotern und ihren Welten.

Durchbrüche im Bereich generativer KI machen 3D-Wahrnehmung, Steuerung, Fertigkeitsplanung und Intelligenz in Robotern möglich. Robotersimulation in großem Umfang ermöglicht es Entwicklern, Roboterfähigkeiten in einer virtuellen Welt, die die Gesetze der Physik nachahmt, zu verfeinern, zu testen und zu optimieren. So können Kosten für die Datenerfassung in der realen Welt gesenkt und die Leistung in sicheren, kontrollierten Umgebungen sichergestellt werden.

NVIDIA hat drei Computer und beschleunigte Entwicklungsplattformen erarbeitet, um Entwicklern die Einrichtung physischer KI zu erleichtern.

Zuerst werden Modelle auf einem Supercomputer trainiert. Entwickler können NVIDIA NeMo auf der NVIDIA DGX-Plattform nutzen, um leistungsstarke Foundation- und generative KI-Modelle zu trainieren und zu optimieren. Außerdem können sie NVIDIA Project GR00T verwenden, eine Initiative zur Entwicklung von universellen Foundation-Modellen für humanoide Roboter, die es erlauben, natürliche Sprache zu verstehen und durch die Beobachtung menschlicher Aktivitäten Bewegungen zu emulieren.

Zweitens stellt NVIDIA Omniverse, das auf NVIDIA OVX-Servern ausgeführt wird, die Entwicklungsplattform und Simulationsumgebung für das Testen und Optimieren physischer KI mit Programmierschnittstellen (APIs) und Frameworks wie NVIDIA Isaac Sim bereit.

Entwickler können Isaac Sim nutzen, um Robotermodelle zu simulieren und zu validieren oder riesige Mengen an physikbasierten synthetischen Daten zu generieren, sodass sie mit dem Training von Robotermodellen starten können. Zudem können Forscher und Entwickler NVIDIA Isaac Lab verwenden, ein Open-Source-Framework für Roboterlernen, das Verstärkungslernen und Imitationslernen von Robotern unterstützt, um das Training und die Verfeinern von Roboterrichtlinien zu beschleunigen.

Schließlich werden trainierte KI-Modelle auf einem Laufzeitcomputer bereitgestellt. NVIDIA Jetson Thor-Robotercomputer wurden speziell für kompakte Onboard-Computing-Anforderungen entwickelt. Ein Ensemble von Modellen, das aus Modellen für Steuerungsrichtlinien, Vision und Sprache besteht, bildet das Robotergehirn und wird auf einem energieeffizienten Onboard-Edge-Computing-System bereitgestellt.

Abhängig von den Workflows und Aufgaben können Roboterhersteller und Entwickler von Foundation-Modellen so viele beschleunigte Computing-Plattformen und -Systeme wie nötig nutzen.

Entwicklung der nächsten Stufe autonomer Anlagen

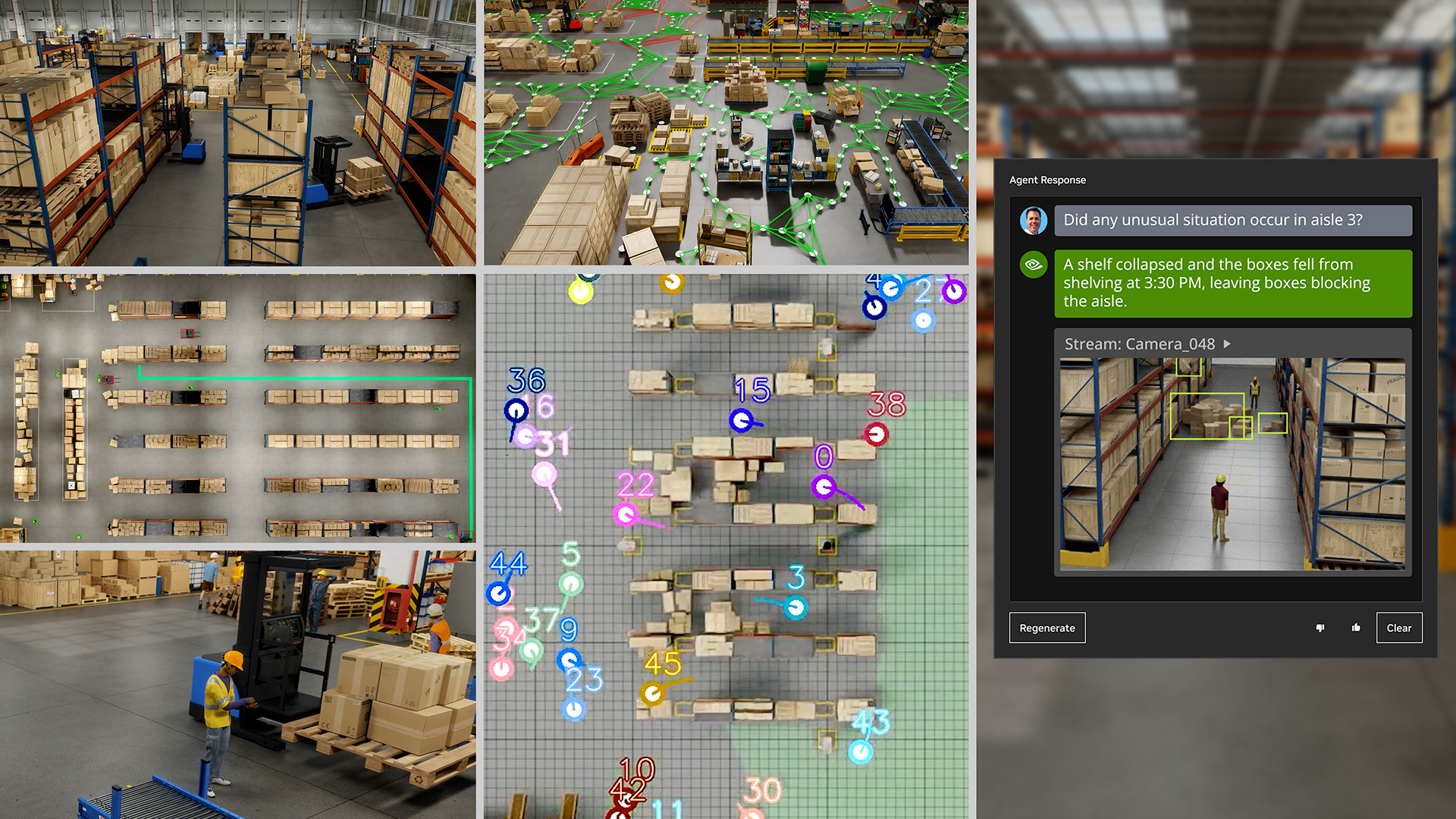

Roboteranlagen sind das Ergebnis einer Zusammenführung all dieser Techniken.

Hersteller wie Foxconn oder Logistikunternehmen wie Amazon Robotics können Teams mit autonomen Robotern zusammenstellen, die neben menschlichen Angestellten arbeiten und Fabrikabläufe mit Hunderten oder Tausenden von Sensoren überwachen.

Solche autonomen Lagerhäuser, Anlagen und Fabriken werden über digitale Zwillinge verfügen. Die digitalen Zwillinge werden für die Planung und Optimierung von Layouts, Betriebssimulationen und vor allem für Software-in-the-Loop-Tests von Roboterflotten verwendet.

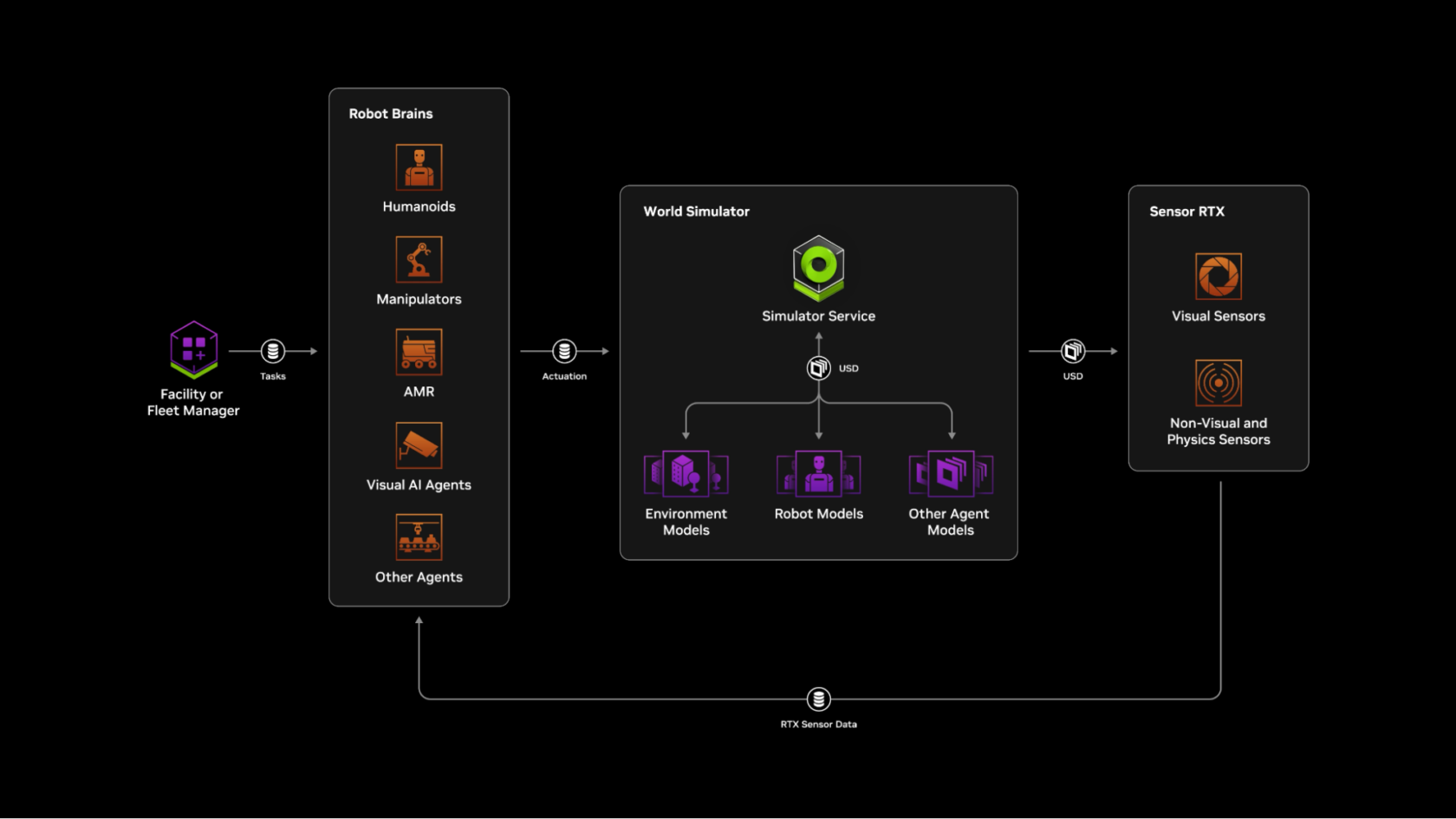

„Mega“ beruht auf Omniverse und ist ein Blueprint für digitale Zwillinge in Fabriken, der es Industrieunternehmen ermöglicht, Roboterflotten in Simulationen zu testen und zu optimieren, bevor sie in physischen Fabriken eingesetzt werden. Das ermöglicht eine nahtlose Integration, optimale Leistung und minimale Unterbrechungen.

Mithilfe von Mega können Entwickler digitale Zwillinge in Fabriken mit virtuellen Robotern und ihren KI-Modellen oder den Gehirnen der Roboter bestücken. Roboter im digitalen Zwilling führen Aufgaben aus, indem sie ihre Umgebung wahrnehmen, Argumente erarbeiten, ihre nächste Bewegung planen und schließlich beabsichtigte Aktionen ausführen.

Solche Aktionen werden in der digitalen Umgebung vom Weltsimulator in Omniverse simuliert, und die Ergebnisse werden von den Roboterhirnen mithilfe von Omniverse-Sensorsimulationen wahrgenommen.

Bei Sensorsimulationen entscheiden die Roboterhirne über die nächste Aktion, und die Schleife wird fortgesetzt, während Mega den Zustand und die Position aller Elemente im digitalen Zwilling der Fabrik akribisch verfolgt.

Mit dieser fortschrittlichen Software-in-the-Loop-Testmethode können Industrieunternehmen Änderungen innerhalb der sicheren Grenzen des digitalen Zwillings von Omniverse simulieren und validieren. So lassen sich potenzielle Probleme antizipieren und mindern, um Risiken und Kosten bei der Bereitstellung in der realen Welt zu senken.

Unterstützung des Entwicklerumfelds mit NVIDIA-Technik

NVIDIA beschleunigt die Arbeit des globalen Ökosystems von Roboterentwicklern und Entwicklern von Roboter-Foundation-Modellen mithilfe von drei Computern.

Universal Robots, ein Unternehmen von Teradyne Robotics, hat NVIDIA Isaac Manipulator, mit Isaac beschleunigte Bibliotheken und KI-Modelle sowie NVIDIA Jetson Orin für die Entwicklung von UR AI Accelerator genutzt. Dabei handelt es sich um ein sofort einsatzbereites Hardware- und Software-Toolkit, mit dem Entwickler von Robotern Anwendungen erarbeiten, die Entwicklung beschleunigen und KI-Produkte schneller einführen können.

RGo Robotics hat NVIDIA Isaac Perceptor verwendet, um seine wheel.me-AMRs überall und jederzeit zu unterstützen und intelligente Entscheidungen zu treffen, indem sie menschenähnliche Wahrnehmungskapazitäten und visuell-räumliche Daten erhalten.

Hersteller von humanoiden Robotern, darunter 1X Technologies, Agility Robotics, Apptronik, Boston Dynamics, Fourier, Galbot, Mentee, Sanctuary AI, Unitree Robotics und XPENG Robotics, setzen auf die Roboterentwicklungsplattform von NVIDIA.

Boston Dynamics nutzt Isaac Sim und Isaac Lab, um Vierfüßler und humanoide Roboter zu entwickeln, die die menschliche Produktivität steigern, Arbeitskräftemangel beheben und die Sicherheit in Lagerhäusern verbessern können.

Fourier verwendet Isaac Sim zum Trainieren von humanoiden Robotern für Bereiche mit hohen Anforderungen an Interaktion und Anpassungsfähigkeit, wie z. B. wissenschaftliche Forschung, Gesundheitswesen und Fertigung.

Mithilfe von Isaac Lab und Isaac Sim konnte Galbot die Entwicklung einer umfangreichen Datenmenge für geschickte Griffe namens DexGraspNet, der für verschiedene geschickte Roboterhände verwendet werden kann, sowie eine Simulationsumgebung für die Bewertung von geschickten Griffmodellen vorantreiben.

Field AI hat mit der Isaac-Plattform und Isaac Lab risikobehaftete Multitasking- und Mehrzweck-Foundation-Modelle für Roboter entwickelt, die in Außenumgebungen sicher arbeiten können.

Das Zeitalter der physischen KI hat begonnen und verändert die Schwerindustrie sowie die Welt der Robotik.

Erste Schritte mit NVIDIA Robotics.