KI treibt eine neue, auf KI-Fabriken beruhende industrielle Revolution an.

Im Gegensatz zu herkömmlichen Rechenzentren können KI-Fabriken mehr als nur Daten speichern und verarbeiten. Sie produzieren Erkenntnisse in großem Maßstab und verwandeln Rohdaten in Echtzeiteinblicke. Für Unternehmen und Länder auf der ganzen Welt bedeutet dies eine erheblich schnellere Wertschöpfung, da KI von einer langfristigen Investition zunehmend zu einem Faktor für sofortige Wettbewerbsvorteile wird. Unternehmen, die heute in zweckspezifische KI-Fabriken investieren, werden in den Bereichen Innovation, Effizienz und Marktdifferenzierung morgen führend sein.

Während ein herkömmliches Rechenzentrum in der Regel unterschiedliche Workloads verarbeitet und für allgemeines Computing dient, sind KI-Fabriken optimiert, um Mehrwert aus KI zu schaffen. Sie orchestrieren den gesamten KI-Lebenszyklus, von der Datenaufnahme über das Training und die Feinabstimmung bis hin zum wichtigsten Teil, der Inferenz von großen Datenmengen.

In KI-Fabriken sind Erkenntnisse kein Neben-, sondern das Hauptprodukt. Diese Erkenntnisse werden am Durchsatz von KI-Token gemessen – den Echtzeitvorhersagen, die Entscheidungen, Automatisierung und völlig neue Dienste unterstützen.

Auch wenn herkömmliche Rechenzentren nicht so bald verschwinden werden: ob sie in KI-Fabriken umgewandelt werden oder sich mit einer solchen verbinden, hängt vom Geschäftsmodell des Unternehmens ab.

Unabhängig von der Anpassungsweise, für die sich Unternehmen entscheiden, generieren KI-Fabriken mit NVIDIA-Technik bereits Erkenntnisse in großem Maßstab und transformieren die Art, wie KI entwickelt, verfeinert und eingesetzt wird.

Die Skalierungsgesetze, die für den Rechenbedarf gelten

In den letzten Jahren wurde KI vor allem für das Trainieren großer Modelle eingesetzt. Doch angesichts der jüngsten Verbreitung von KI-Reasoning-Modellen steht Inferenz jetzt im Mittelpunkt der KI-Ökonomie. Die folgenden drei zentralen Skalierungsgesetze zeigen die Gründe dafür auf.

- Pre-Training-Skalierung: Größere Datenmengen und Modellparameter führen zu einer vorhersehbaren Steigerung der Anzahl der gewonnenen Erkenntnisse. Das Erreichen dieser Phase erfordert jedoch erhebliche Investitionen in qualifizierte Experten, Datenkuration und Rechenressourcen. In den letzten fünf Jahren hat Pre-Training-Skalierung die Rechenanforderungen um das 50-Millionen-Fache erhöht. Sobald ein Modell jedoch trainiert wurde, wird die Entwicklung von darauf aufbauenden Modellen erheblich erleichtert.

- Post-Training-Skalierung: Die Feinabstimmung von KI-Modellen für spezifische reale Anwendungen erfordert während der KI-Inferenz 30-mal mehr Rechenleistung als im Pre-Training. Da Unternehmen vorhandene Modelle an ihre individuellen Anforderungen anpassen, steigt die kumulative Nachfrage nach KI-Infrastruktur sprunghaft an.

- Skalierung in der Testzeit (auch Long Thinking): Fortschrittliche KI-Anwendungen wie agentenbasierte KI oder physische KI erfordern iteratives Reasoning, bei dem Modelle mehrere mögliche Antworten untersuchen, bevor sie die beste auswählen. Dies erfordert bis zu 100-mal mehr Rechenleistung als herkömmliche Inferenz.

Traditionelle Rechenzentren sind nicht für diese neue KI-Ära ausgelegt. KI-Fabriken werden speziell für die Optimierung und Aufrechterhaltung dieses massiven Bedarfs an Rechenleistung konzipiert und bieten einen idealen Pfad für die Zukunft von KI-Inferenz und -Bereitstellung.

Neugestaltung von Branchen und Ökonomien mithilfe von Token

Auf der ganzen Welt arbeiten Regierungen und Unternehmen daran, KI-Fabriken zu errichten, um Wirtschaftswachstum, Innovation und Effizienz zu fördern.

Das Gemeinsame Unternehmen für europäisches Hochleistungsrechnen kündigte kürzlich Pläne an, in Zusammenarbeit mit 17 Mitgliedstaaten der Europäischen Union sieben KI-Fabriken zu bauen.

Dies folgt auf eine weltweite Welle von Investitionen in KI-Fabriken, mit denen Unternehmen und Länder KI-gestütztes Wirtschaftswachstum in allen Branchen und Regionen beschleunigen:

- Indien: Yotta Data Services hat sich mit NVIDIA zusammengetan, um die Plattform Shakti Cloud einzuführen, die dazu beiträgt, den Zugriff auf fortschrittliche GPU-Ressourcen zu demokratisieren. Durch die Integration von NVIDIA AI Enterprise-Software mit Open-Source-Tools bietet Yotta eine nahtlose Umgebung für die Entwicklung und Bereitstellung von KI.

- Japan: Führende Cloud-Anbieter, darunter GMO Internet, Highreso, KDDI, Rutilea und SAKURA internet, entwickeln derzeit eine auf NVIDIA-Technik basierende KI-Infrastruktur, um Branchen wie Robotik, Automobilindustrie, Gesundheitswesen und Telekommunikation zu transformieren.

- Norwegen: Telenor hat eine mit NVIDIA-Technik ausgestattete KI-Fabrik in Betrieb genommen, um die Einführung von KI in der nordischen Region zu beschleunigen, wobei der Schwerpunkt auf der Weiterbildung von Belegschaften und Nachhaltigkeit liegt.

Diese Initiativen unterstreichen eine globale Realität: KI-Fabriken werden schnell zu einer unverzichtbaren nationalen Infrastruktur, gleichrangig mit der Telekommunikations- und Energiebranche.

In einer KI-Fabrik: Wo Erkenntnisse produziert werden

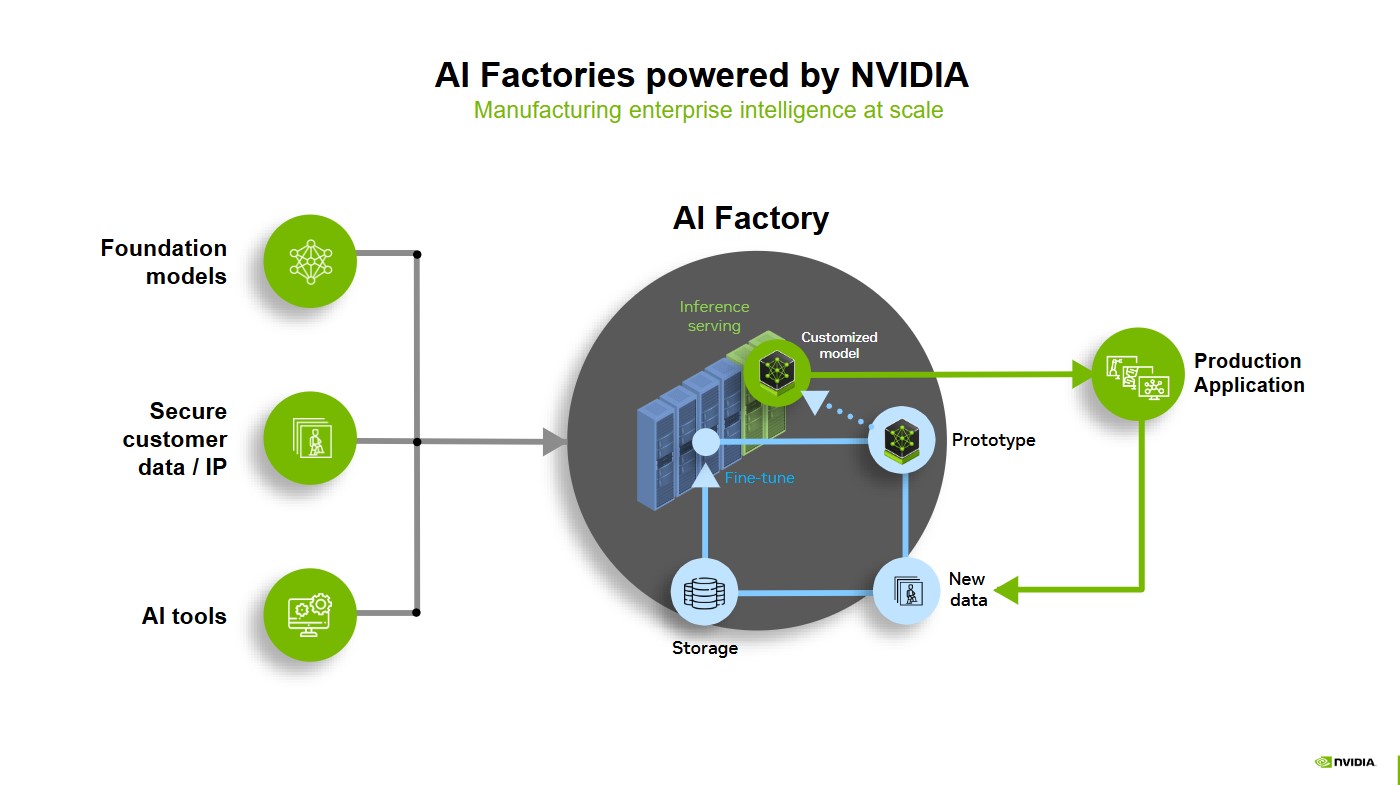

Foundation-Modelle, sichere Kundendaten und KI-Tools sind die Rohstoffe für die Versorgung von KI-Fabriken, in denen Inferenzbereitstellung, Prototyping und Feinabstimmung leistungsstarke, maßgeschneiderte Modelle bilden, die bereit für die Produktion sind.

Wenn diese Modelle in realen Anwendungen eingesetzt werden, lernen sie kontinuierlich aus neuen Daten, die gespeichert, verfeinert und mittels eines Daten-Flywheel in das System zurückgeführt werden. Dieser Optimierungszyklus stellt sicher, dass KI anpassungsfähig sowie effizient ist und sich ständig verbessert. Das erlaubt eine Gewinnung von Unternehmensdaten in einzigartigem Maßstab.

Vorteile von KI-Fabriken mit NVIDIA AI auf Full-Stack-Basis

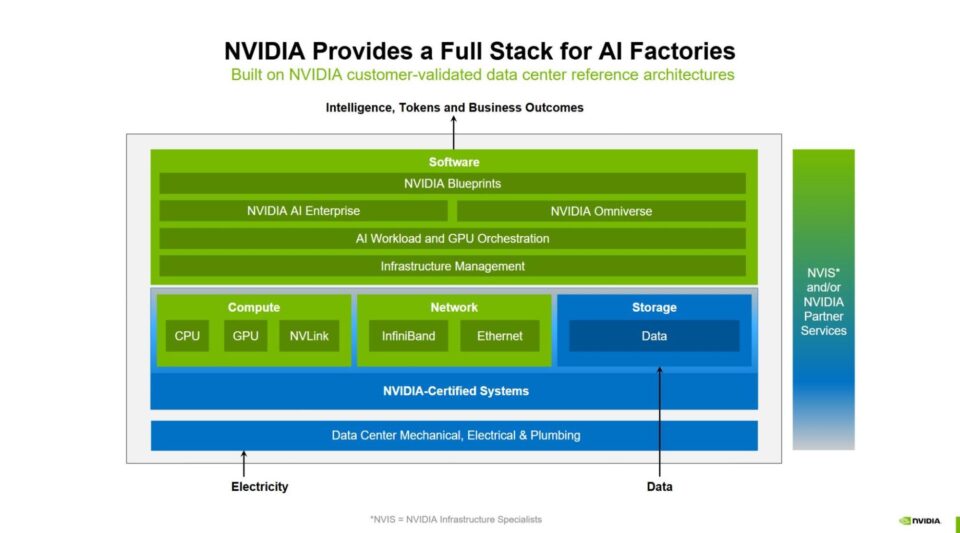

NVIDIA bietet einen vollständigen, integrierten KI-Fabrik-Stack, bei dem jede Ebene – vom Chip bis zur Software – für Training, Feinabstimmung und Inferenz in großem Maßstab optimiert ist. Dieser Full-Stack-Ansatz stellt sicher, dass Unternehmen KI-Fabriken bereitstellen können, die kostengünstig, leistungsstark und zukunftssicher für das exponentielle Wachstum von KI sind.

Gemeinsam mit Partnern aus seinem Technologieumfeld hat NVIDIA Bausteine für die Full-Stack-KI-Fabrik entwickelt, die Folgendes bieten:

- Extrem hohe Rechenleistung

- Fortschrittliche Netzwerktechnik

- Infrastrukturmanagement und Workload-Orchestrierung

- Das größte Technologieumfeld für KI-Inferenz

- Datenspeicher und Datenplattformen

- Blueprints für Design und Optimierung

- Referenzarchitekturen

- Flexible Bereitstellung in jedem Unternehmen

Hohe Rechenleistung

Das Herzstück jeder KI-Fabrik ist ihre Rechenleistung. Von NVIDIA Hopper bis hin zu NVIDIA Blackwell: NVIDIA ermöglicht das weltweit leistungsstärkste beschleunigte Computing für die neue industrielle Revolution. Mit der Rack-Scale-Lösung GB300 NVL72 auf Basis von NVIDIA Blackwell Ultra können KI-Fabriken beim KI-Reasoning bis zu 50-mal so viel Leistung erzielen und so neue Maßstäbe in Sachen Effizienz und Skalierung setzen.

Der NVIDIA DGX SuperPOD ist ein Paradebeispiel für eine schlüsselfertige KI-Fabrik für Unternehmen, die das Beste der beschleunigten Computing-Kapazitäten von NVIDIA integriert. NVIDIA DGX Cloud stellt eine KI-Fabrik bereit, die mit NVIDIA-Technik für beschleunigtes Computing mit hoher Leistung in der Cloud sorgt.

Globale Systempartner entwickeln für ihre Kunden Full-Stack-KI-Fabriken, die auf mit NVIDIA-Technik beschleunigtem Computing basieren – jetzt einschließlich der Rack-Scale-Lösungen NVIDIA GB200 NVL72 und GB300 NVL72.

Fortgeschrittene Netzwerktechnik

Die Bewegung von Daten in großem Maßstab erfordert nahtlose, leistungsstarke Konnektivität im gesamten KI-Fabrik-Stack. NVIDIA NVLink und NVLink Switch sorgen für schnelle Kommunikation mit mehreren GPUs und beschleunigen die Datenübertragung innerhalb und zwischen Knoten.

KI-Fabriken erfordern zudem ein robustes Netzwerk-Backbone. Die Plattformen NVIDIA Quantum InfiniBand, NVIDIA Spectrum-X Ethernet und NVIDIA BlueField Networking reduzieren Engpässe und sorgen in riesigen GPU-Clustern für einen effizienten Datenaustausch mit hohem Durchsatz. Diese End-to-End-Integration ist für die Skalierung von KI-Workloads auf Millionen von GPUs unerlässlich und ermöglicht bahnbrechende Leistung beim Trainieren und Inferenzieren.

Infrastrukturmanagement und Workload-Orchestrierung

Unternehmen benötigen eine Möglichkeit, die Leistung von KI-Infrastruktur mit der Agilität, Effizienz und Skalierung eines Hyperscalers zu nutzen, jedoch ohne dass die IT-Abteilung durch Kosten, Komplexität und erforderliche Fachkenntnisse belastet wird.

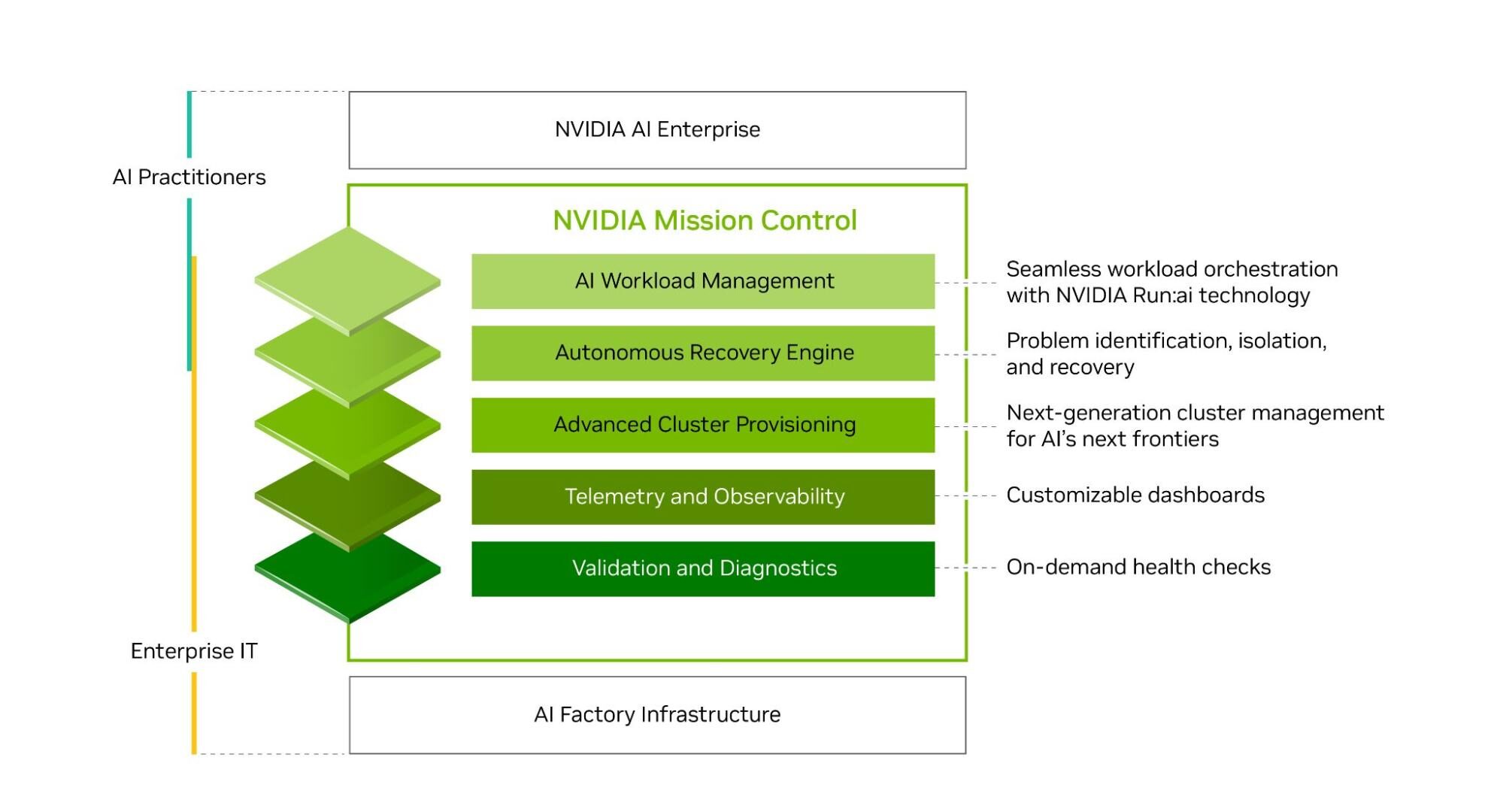

Mit NVIDIA Run:ai können Unternehmen von einer nahtlosen KI-Workload-Orchestrierung und GPU-Verwaltung profitieren, was die Ressourcenauslastung optimiert und gleichzeitig KI-Experimente beschleunigt sowie Workloads skaliert. Die Software NVIDIA Mission Control, die NVIDIA Run:ai-Technologie umfasst, optimiert den KI-Fabrikbetrieb von Workloads bis hin zur Infrastruktur und bietet gleichzeitig Full-Stack-Intelligence, die für erstklassige Infrastrukturresilienz sorgt.

Das größte Technologieumfeld für KI-Inferenz

KI-Fabriken benötigen die richtigen Tools, um Daten in Erkenntnisse verwandeln zu können. Die NVIDIA AI-Inferenzplattform umfasst das Technologieumfeld von NVIDIA TensorRT, NVIDIA Dynamo und NVIDIA NIM-Microservices, die alle (bald) ein Teil der NVIDIA AI Enterprise-Softwareplattform sind. Die Plattform beinhaltet die branchenweit umfassendste Suite an KI-Beschleunigungsbibliotheken und optimierter Software. Sie sorgt für maximale Inferenzleistung, extrem niedrige Latenz und hohen Durchsatz.

Datenspeicher und Datenplattformen

Daten treiben KI-Anwendungen an. Aufgrund des rasant wachsenden Umfangs und der Komplexität von Unternehmensdaten ist eine effektive Nutzung jedoch häufig zu kostspielig und zeitaufwendig. Um im Zeitalter von KI erfolgreich zu sein, müssen Unternehmen das volle Potenzial ihrer Daten nutzen.

Die NVIDIA AI-Datenplattform ist ein anpassbares Referenzdesign für die Entwicklung einer neuen Klasse von KI-Infrastruktur für anspruchsvolle KI-Inferenz-Workloads. Partner für NVIDIA-zertifizierten Datenspeicher arbeiten mit NVIDIA zusammen, um maßgeschneiderte KI-Datenplattformen zu entwickeln, die Unternehmensdaten nutzen können, um komplexe Abfragen zu verstehen und zu beantworten.

Blueprints für Design und Optimierung

Für den Entwurf und die Optimierung von KI-Fabriken können Teams den NVIDIA Omniverse Blueprint für KI-Fabrikdesign und -betrieb nutzen. Mit dem Blueprint können Ingenieure die Infrastruktur der KI-Fabrik vor der Bereitstellung mithilfe von digitalen Zwillingen planen, testen und optimieren. Durch die Reduzierung von Risiken und Unsicherheiten trägt der Blueprint zur Vermeidung von kostspieligen Ausfallzeiten bei – ein entscheidender Faktor für Betreiber von KI-Fabriken.

In einer KI-Fabrik mit 1 Gigawatt kann ein einzelner Ausfalltag mehr als 100 Mio. USD kosten. Durch die Verringerung der Komplexität im Vorfeld und die parallele Arbeit von isolierten Teams aus den Bereichen IT, Mechanik, Elektrotechnik, Energietechnik und Netzwerktechnik beschleunigt der Blueprint die Bereitstellung und sorgt für betriebliche Resilienz.

Referenzarchitekturen

NVIDIA Enterprise-Referenzarchitekturen und NVIDIA Cloud Partner-Referenzarchitekturen bieten eine Roadmap für Partner, die KI-Fabriken entwerfen und bereitstellen wollen. Sie helfen Unternehmen und Cloud-Anbietern bei der Entwicklung skalierbarer, leistungsstarker und sicherer KI-Infrastrukturen, die auf NVIDIA-zertifizierten Systemen mit dem NVIDIA AI-Software-Stack und dem Technologieumfeld aus Partnern basiert.

Jede Ebene des KI-Fabrik-Stacks ist auf effizientes Computing angewiesen, um steigende KI-Anforderungen erfüllen zu können. Mit NVIDIA-Technik beschleunigtes Computing dient als Grundlage für den gesamten Stack und bietet die höchste Verarbeitungsleistung pro Watt, um sicherzustellen, dass KI-Fabriken mit maximaler Energieeffizienz arbeiten. Mithilfe einer energieeffizienten Architektur und Flüssigkeitskühlung können Unternehmen KI skalieren und gleichzeitig Energieausgaben möglichst gering halten.

Flexible Bereitstellung in jedem Unternehmen

Mit den Full-Stack-Technologien von NVIDIA können Unternehmen KI-Fabriken ganz einfach entwickeln, bereitstellen und an die bevorzugten IT-Verbrauchsmodelle und betrieblichen Anforderungen von Kunden anpassen.

Manche Unternehmen entscheiden sich für lokale KI-Fabriken, um die volle Kontrolle über Daten und Leistung zu behalten, während andere für hohe Skalierbarkeit und Flexibilität Cloud-basierte Lösungen nutzen. Viele wenden sich an ihre vertrauenswürdigen globalen Systempartner, um vorab integrierte Lösungen zur Beschleunigung der Bereitstellung zu erhalten.

Lokal

NVIDIA DGX SuperPOD ist eine schlüsselfertige Infrastrukturlösung für KI-Fabriken, die für die anspruchsvollsten KI-Trainings- und Inferenz-Workloads eine beschleunigte Infrastruktur mit skalierbarer Leistung bereitstellt. Sie verfügt über eine designoptimierte Kombination aus KI-Computing, Netzwerk-Fabric, Datenspeicher und NVIDIA Mission Control-Software, um es Unternehmen zu ermöglichen, KI-Fabriken in Wochen statt Monaten betriebsbereit zu machen – und das mit erstklassiger Verfügbarkeit, Resilienz und Auslastung.

Lösungen für KI-Fabriken werden auch über das globale Technologieumfeld von NVIDIA mit Partnern für Unternehmenstechnologie und NVIDIA-zertifizierten Systemen angeboten. Sie stellen branchenführende Hardware- und Softwaretechnologie in Kombination mit Fachwissen zu Rechenzentrumssystemen und Innovationen im Bereich der Flüssigkeitskühlung bereit, um Unternehmen zu helfen, ihre KI-Projekte abzusichern und die Rentabilität ihrer KI-Fabrik-Implementierungen zu beschleunigen.

Diese globalen Systempartner bieten auf der Grundlage von NVIDIA-Referenzarchitekturen Full-Stack-Lösungen an – integriert mit durch NVIDIA-Technik beschleunigter Rechenleistung, leistungsstarker Netzwerktechnik und KI-Software, um Kunden bei der erfolgreichen Bereitstellung von KI-Fabriken und Fertigungsdaten in großem Maßstab zu unterstützen.

In der Cloud

Für Unternehmen, die für ihre KI-Fabrik eine cloudbasierte Lösung nutzen möchten, bietet NVIDIA DGX Cloud eine einheitliche Plattform in führenden Clouds, mit der sich KI-Anwendungen bequem entwickeln, anpassen und bereitstellen lassen. Jede Ebene von DGX Cloud wird von NVIDIA optimiert und vollständig verwaltet und bietet das Beste von NVIDIA AI in der Cloud. Die Lösung verfügt über Software der Enterprise-Klasse und riesige, zusammenhängende Cluster bei führenden Cloud-Anbietern, um skalierbare Rechenressourcen bereitzustellen, die selbst für anspruchsvollste KI-Trainings-Workloads perfekt geeignet sind.

DGX Cloud enthält außerdem eine dynamische und skalierbare serverlose Inferenzplattform, die in Hybrid- und Multi-Cloud-Umgebungen hohen Durchsatz für KI-Token bietet, wodurch Infrastrukturkomplexität und Betriebskosten erheblich reduziert werden.

Durch die Bereitstellung einer Full-Stack-Plattform, die Hardware, Software, Partner aus dem Technologieumfeld und Referenzarchitekturen integriert, unterstützt NVIDIA Unternehmen beim Aufbau von KI-Fabriken, die kostengünstig, skalierbar und leistungsfähig sind. So können sich Unternehmen leicht auf die nächste industrielle Revolution vorbereiten.

Erfahren Sie mehr über NVIDIA KI-Fabriken.

Siehe Hinweis zu Informationen über Softwareprodukte.