OpenAI und NVIDIA haben gerade eine bahnbrechende Partnerschaft für KI-Infrastruktur angekündigt – eine Initiative, die die Rechenleistung von OpenAI mit Multi-Gigawatt-Rechenzentren skalieren wird, die von Millionen NVIDIA-GPUs angetrieben werden.

Heute früh sprachen die CEOs der beiden Unternehmen und der President von OpenAI mit Jon Fortt von CNBC darüber, was dies für die nächste Generation der KI-Entwicklung und -Bereitstellung bedeutet.

„Dies ist das größte KI-Infrastrukturprojekt in der Geschichte“, sagte NVIDIA-Gründer und CEO Jensen Huang im Interview. „Bei dieser Partnerschaft geht es darum, eine KI-Infrastruktur aufzubauen, die es ermöglicht, die KI aus den Laboren in die Welt hinauszutragen.“

Im Rahmen dieser Partnerschaft wird OpenAI mindestens 10 Gigawatt an NVIDIA-Systemen für die KI-Infrastruktur der nächsten Generation von OpenAI bereitstellen, darunter auch die NVIDIA Vera Rubin-Plattform. NVIDIA beabsichtigt darüber hinaus, zusammen mit jedem neu bereitgestellten Gigawatt schrittweise bis zu 100 Milliarden US-Dollar in OpenAI zu investieren.

„Es existiert kein anderer Partner als NVIDIA, der dies in diesem Umfang und mit dieser Geschwindigkeit leisten kann“, sagte Sam Altman, der CEO von OpenAI.

Die im Rahmen dieser Vereinbarung errichteten KI-Fabriken mit Millionen GPUs werden OpenAI die Möglichkeit eröffnen, die Trainings- und Inferenzanforderungen seiner KI-Modelle der nächsten Generation zu erfüllen.

„Der Aufbau dieser Infrastruktur ist entscheidend für alles, was wir vorhaben“, sagte Altman. „Das ist der Kraftstoff, den wir brauchen, um Verbesserungen voranzutreiben, bessere Modelle zu entwickeln, den Umsatz und einfach alles zu steigern.“

Aufbau einer Infrastruktur mit Millionen GPUs zur Erfüllung der KI-Nachfrage

Seit OpenAI ChatGPT eingeführt hat – das im Jahr 2022 als schnellste Anwendung in der Geschichte die Zahl von 100 Millionen Benutzern erreicht hat –, hat das Unternehmen seine Benutzerbasis auf über 700 Millionen wöchentlich aktive Benutzer ausgebaut und immer fortschrittlichere Funktionen bereitgestellt, darunter die Unterstützung für agentenbasierte KI, KI-Reasoning, multimodale Daten und längere Kontextfenster.

Damit das Unternehmen seine nächste Wachstumsphase unterstützen kann, muss die KI-Infrastruktur skaliert werden, um nicht nur den Trainings-, sondern auch den Inferenzanforderungen der fortschrittlichsten Modelle für weltweite Benutzer agentenbasierter und Reasoning-KI gerecht zu werden.

„Die Kosten pro Intelligenzeinheit werden immer weiter sinken, was wir großartig finden“, sagte Altman. „Auf der anderen Seite erreicht die Spitze der KI, die maximale intellektuelle Leistungsfähigkeit, immer höhere Werte. Und das ermöglicht eine immer breitere Nutzung – und das in großem Umfang.“

Ohne ausreichende Rechenressourcen, erklärte Altman, müssten sich die Menschen zwischen wirkungsvollen Anwendungsfällen entscheiden – ob sie beispielsweise ein Krebsheilmittel erforschen oder kostenlose Bildung anbieten wollen.

„Niemand möchte eine solche Entscheidung treffen“, sagte er. „Und so wird immer deutlicher, dass die Antwort nur in deutlich höheren Kapazitäten liegen kann, damit wir den enormen Bedarf und die damit verbundenen Möglichkeiten bedienen können.“

Das erste Gigawatt aus NVIDIA-Systemen, gebaut mit NVIDIA Vera Rubin-GPUs, wird in der zweiten Hälfte des Jahres 2026 seine ersten Token generieren.

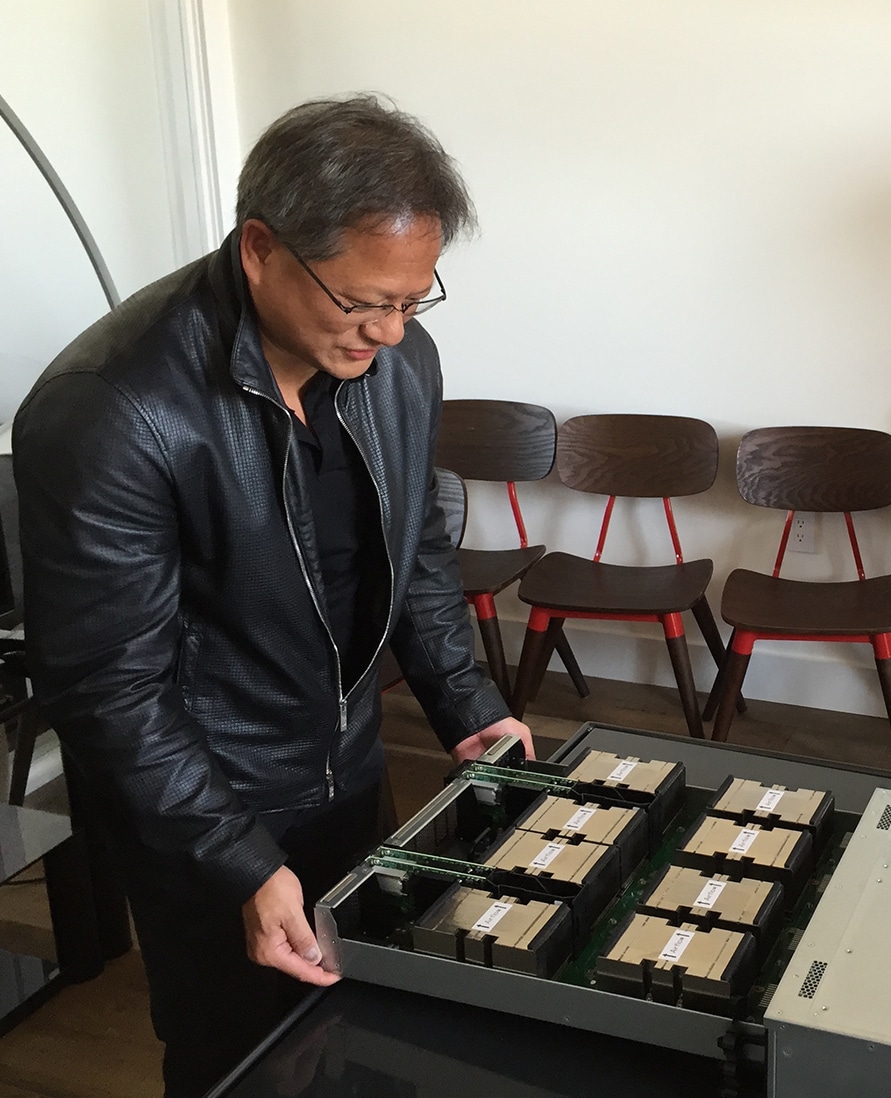

Die Partnerschaft basiert auf einer langjährigen Zusammenarbeit zwischen NVIDIA und OpenAI, die 2016 mit der persönlichen Übergabe des ersten NVIDIA DGX-Systems durch Huang an das Unternehmen begann.

„Dies liefert eine Milliarde Mal die Rechenleistung des ersten Servers“, sagte Greg Brockman, President von OpenAI. „Wir sind in der Lage, wirklich neue Durchbrüche zu erschaffen, neue Modelle zu entwickeln, die jeden Einzelnen und jedes Unternehmen mit mehr Mitteln versorgen, weil wir in der Lage sein werden, die nächste Skalierungsstufe zu erreichen.“

Huang betonte, dies sei zwar der Beginn eines massiven Ausbaus der KI-Infrastruktur auf der ganzen Welt, aber erst der Anfang.

„Wir werden buchstäblich jede Anwendung, jeden Anwendungsfall und jedes Gerät mit Intelligenz verbinden – und stehen dabei erst am Anfang“, sagte Huang. „Das sind nur die ersten 10 Gigawatt, das versichere ich Ihnen.“

Sehen Sie sich unten das CNBC-Interview an.