Open-Source-KI beschleunigt Innovationen in verschiedenen Branchen. NVIDIA DGX Spark und DGX Station wurden entwickelt, um Entwicklern dabei zu helfen, Innovationen in die Tat umzusetzen.

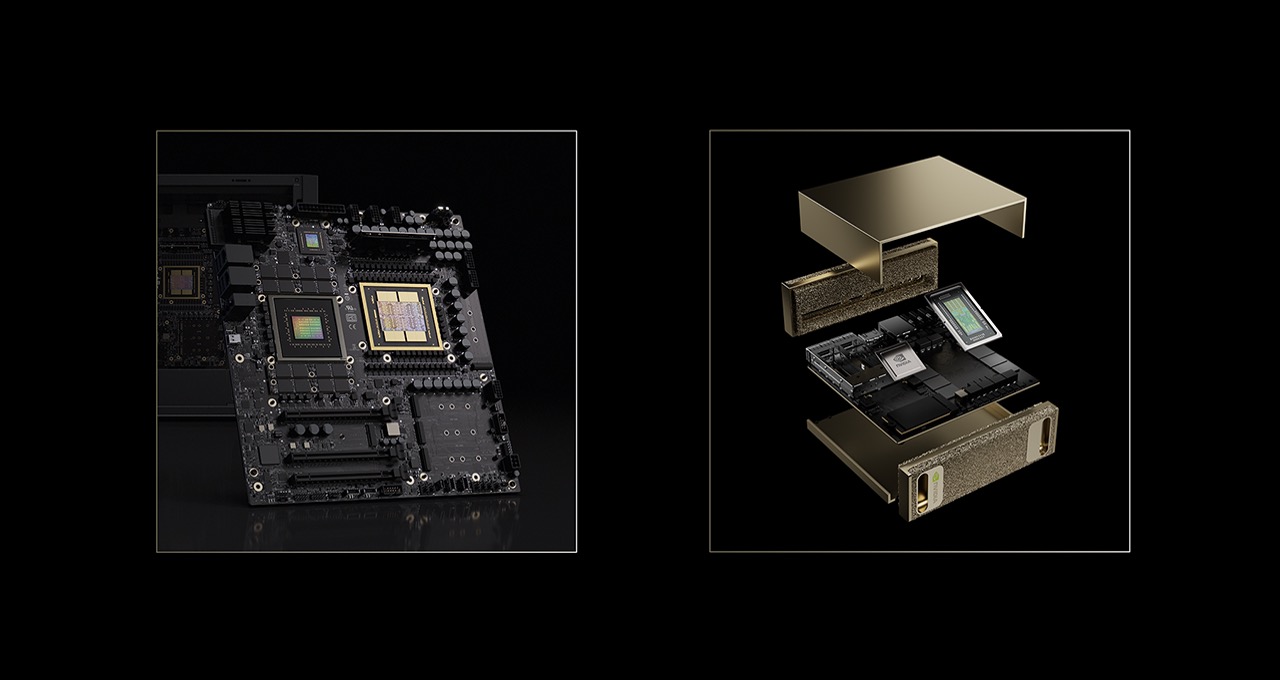

NVIDIA hat auf der CES vorgestellt, wie Entwickler mit den Supercomputern DGX Spark und DGX Station die neuesten offenen und fortschrittlichen KI-Modelle auf einem lokalen Deskside-System nutzen können, von Modellen mit 100 Milliarden Parametern auf DGX Spark bis hin zu Modellen mit einer Billion Parametern auf DGX Station.

Diese Systeme basieren auf der NVIDIA Grace Blackwell-Architektur mit großem einheitlichem Speicher und KI-Leistung auf Petaflop-Niveau und bieten Entwicklern neue Möglichkeiten für die lokale Entwicklung und die einfache Skalierung in die Cloud.

Leistungssteigerung bei Open-Source-KI-Modellen

Eine Vielzahl hochoptimierter offener Modelle, die zuvor in einem Rechenzentrum ausgeführt werden mussten, können jetzt auf dem Desktop auf DGX Spark und DGX Station beschleunigt werden, dank kontinuierlicher Fortschritte in der Modelloptimierung und der Zusammenarbeit mit der Open-Source-Community.

DGX Spark ist mit NVIDIA KI-Software und NVIDIA CUDA-X-Bibliotheken vorkonfiguriert und bietet Entwicklern, Forschern und Datenwissenschaftlern eine leistungsstarke Plug-and-Play-Optimierung zur Entwicklung, Feinabstimmung und Ausführung von KI.

DGX Spark bietet die Grundlage für alle Entwickler, um die neuesten KI-Modelle direkt am Schreibtisch auszuführen; mit der DGX Station können Unternehmen und Forschungslabore fortschrittlichste, groß angelegte KI-Modelle der neuesten Generation ausführen. Die Systeme unterstützen die Ausführung der neuesten Frameworks und Open-Source-Modelle – einschließlich der kürzlich angekündigten NVIDIA Nemotron 3-Modelle – direkt auf Desktops.

Die NVIDIA Blackwell-Architektur, die DGX Spark antreibt, umfasst das NVFP4-Datenformat, mit dem KI-Modelle um bis zu 70 % komprimiert werden und gleichzeitig die Leistung ohne Beeinträchtigung der Intelligenz gesteigert wird.

Die Zusammenarbeit von NVIDIA mit dem Open-Source-Software-Ökosystem, wie die Arbeit mit llama.cpp, steigert die Leistung und ermöglicht bei der Ausführung modernster KI-Modelle auf DGX Spark eine durchschnittliche Verbesserung von 35 %. Llama.cpp umfasst außerdem ein Upgrade der Benutzerfreundlichkeit, das die Ladezeiten für LLM beschleunigt.

DGX Station mit dem GB300 Grace Blackwell Ultra Superchip und 775 GB kohärentem Speicher mit FP4-Präzision kann Modelle mit bis zu 1 Billion Parametern verarbeiten und bietet KI-Laboren modernste Rechenleistung für groß angelegte Modelle direkt vom Desktop aus. Dazu gehört eine Vielzahl fortschrittlicher KI-Modelle, darunter Kimi-K2 Thinking, DeepSeek-V3.2, Mistral Large 3, Meta Llama 4 Maverick, Qwen3 und OpenAI gpt-oss-120b.

„NVIDIA GB300 wird in der Regel als Rack-Scale-System bereitgestellt“, erklärt Kaichao You, Hauptbetreuer von vLLM. „Dies macht es für Projekte wie vLLM schwierig, direkt auf dem leistungsstarken GB300-Superchip zu testen und zu entwickeln. DGX Station ändert diese Dynamik. Durch die Bereitstellung von GB300 in einem kompakten System mit Formfaktor auf dem Schreibtisch ermöglicht DGX Station vLLM, GB300-spezifische Funktionen zu deutlich geringeren Kosten zu testen und zu entwickeln. Dies beschleunigt die Entwicklungszyklen und ermöglicht es vLLM, kontinuierlich gegen GB300 zu validieren und zu optimieren.

„DGX Station bringt GPU-Funktionen der Rechenzentrumsklasse direkt in mein Zimmer“, sagt Jerry Zhou, Community-Beitragender von SGLang. „Es ist leistungsstark genug, um sehr große Modelle wie Qwen3-235B zu unterstützen, Trainingsframeworks mit großen Modellkonfigurationen zu testen und CUDA-Kernel mit extrem großen Matrixgrößen zu entwickeln – und das alles lokal, ohne auf Cloud-Racks angewiesen zu sein. Dies verkürzt die Iterationsschleife für die System- und Framework-Entwicklung erheblich.“

NVIDIA stellt die Funktionen der DGX Station live auf der CES vor und zeigt:

- LLM-Pre-Training, das mit rasanten 250.000 Token pro Sekunde durchgeführt wird.

- Eine Visualisierung von Millionen von Datenpunkten in Kategorien-Clustern. Der Workflow für die Themenmodellierung nutzt Techniken und Algorithmen des maschinellen Lernens, die durch die NVIDIA cuML-Bibliothek beschleunigt werden.

- Visualisierung umfangreicher Wissensdatenbanken mit hoher Genauigkeit mit Text to Knowledge Graph und Llama 3.3 Nemotron Super 49B.

Erweiterung von KI- und Creator-Workflows.

DGX Spark und Station wurden speziell für die Unterstützung des gesamten KI-Entwicklungszyklus entwickelt, vom Prototyping und der Feinabstimmung bis hin zur Inferenz und Datenwissenschaft, für eine Vielzahl von branchenspezifischen KI-Anwendungen in den Bereichen Gesundheitswesen, Robotik, Einzelhandel, kreative Workflows und weiteren.

Für Content Creator unterstützen die neuesten Modelle zur Diffusion und Videogenerierung, darunter FLUX.2 und FLUX.1 von Black Forest Labs und Qwen-Image von Alibaba, jetzt NVFP4, was den Speicherbedarf reduziert und die Leistung beschleunigt. Das neue LTX-2-Videomodell von Lightricks steht jetzt zum Download zur Verfügung, einschließlich der NVFP8-quantisierten Checkpoints für NVIDIA-GPUs und bietet eine Qualität, die der besten Cloud-Modelle entspricht.

Live-Demonstrationen der CES zeigen, wie DGX Spark anspruchsvolle Workloads zur Videogenerierung von Creator-Laptops übernehmen kann und im Vergleich zu einem erstklassigen MacBook Pro mit M4 Max eine achtfache Beschleunigung bietet, wodurch lokale Systeme für unterbrechungsfreie kreative Arbeit entlastet werden.

Die Open-Source-Modding-Plattform RTX Remix wird 3D-Künstlern und Moddern bald die Möglichkeit geben, mit DGX Spark schneller mit generativer KI zu arbeiten. Zusätzliche Demonstrationen auf der CES zeigen, wie ein Mod-Team die gesamte Asset-Erstellung auf DGX Spark auslagern kann, wodurch es seine PCs ohne Unterbrechungen für die Modifizierung einsetzen kann und Änderungen im Spiel in Echtzeit sehen kann.

KI-Programmierassistenten verändern auch die Produktivität von Entwicklern. Auf der CES zeigt NVIDIA einen lokalen CUDA-Codierungsassistenten, der auf NVIDIA Nsight basiert und auf DGX Spark läuft. Entwickler können so den Quellcode lokal und sicher speichern und gleichzeitig von der KI-gestützten Unternehmensentwicklung profitieren.

Branchenführer bestätigen die Umstellung auf lokale KI

Da die Nachfrage nach sicherer, leistungsstarker KI am Edge steigt, gewinnt DGX Spark in der gesamten Branche an Bedeutung.

Softwareführer und Open-Source-Innovatoren sowie globale Workstation-Partner setzen auf DGX Spark, um lokale Inferenz, agentische Workflows und Abruf-gestützte Generierung ohne die Komplexität einer zentralisierten Infrastruktur zu ermöglichen.

Ihre Perspektiven zeigen, wie DGX Spark eine schnellere Iteration, mehr Kontrolle über Daten und IP sowie neue, interaktivere KI-Erlebnisse auf dem Desktop ermöglicht.

Auf der CES zeigt NVIDIA, wie man die Verarbeitungsleistung von DGX Spark mit dem Hugging Face Reachy Mini-Roboter einsetzen kann, um KI-Agenten in die reale Welt zu bringen.

„Offene Modelle geben Entwicklern die Freiheit, KI auf ihre Weise zu entwickeln, und DGX Spark bringt diese Leistung direkt auf den Desktop“, erklärt Jeff Boudier, Vice President of Product bei Hugging Face. „Wenn Sie es mit Reachy Mini verbinden, werden Ihre lokalen KI-Agenten greifbar und erhalten eine eigene Stimme.“ Sie können Sie sehen, Ihnen zuhören und mit ausdrucksstarken Bewegungen reagieren – sie machen aus leistungsstarker KI etwas, mit dem Sie wirklich interagieren können.“

Hugging Face und NVIDIA haben eine Schritt-für-Schritt-Anleitung für die Entwicklung eines interaktiven KI-Agenten mit DGX Spark und Reachy Mini veröffentlicht.

„DGX Spark bringt KI-Inferenz an die Edge“, erklärte Ed Anuff, Vizepräsident für Daten- und KI-Plattformstrategie bei IBM. „Mit OpenRAG auf Spark erhalten Benutzer einen vollständigen, in sich geschlossenen RAG-Stack aus einer Hand – Extraktion, Einbettung, Abruf und Inferenz.“

„Für Unternehmen, die die volle Kontrolle über Sicherheit, Governance und geistiges Eigentum benötigen, bietet NVIDIA DGX Spark KI-Leistung der Petaflop-Klasse für die Kunden von JetBrains“, erklärte Kirill Skrygan, CEO von JetBrains. „Ob die Kunden eine Cloud-, lokale oder hybride Bereitstellung bevorzugen – JetBrains AI wurde entwickelt, um ihre Anforderungen zu erfüllen.“

TRINITY, ein intelligentes, selbstausgleichendes dreirädriges Einpersonenfahrzeug für den städtischen Verkehr, wird auf der CES vorgestellt und nutzt DGX Spark als KI-gestütztes Gehirn für die KI-Inferenz von Open-Source-Workloads für Echtzeit-Sprachmodelle.

„TRINITY steht für die Zukunft der Mikromobilität, in der Menschen, Fahrzeuge und KI-Agenten nahtlos zusammenarbeiten“, erklärt will.i.am. „Mit NVIDIA DGX Spark als KI-Gehirn bietet TRINITY dialogorientierte Workflows für Zielverfolgung und verändert die Art und Weise, wie Menschen in vernetzten Städten mit der Mobilität interagieren. Es ist Gehirn auf Rädern, das vom Agenten aus entworfen wurde.”

Beschleunigte Einführung von KI für Entwickler

Die DGX Spark-Playbooks helfen Entwicklern dabei, schnell mit realen KI-Projekten loszulegen. Auf der CES erweitert NVIDIA diese Bibliothek mit sechs neuen Playbooks und vier wichtigen Updates, die Themen wie das neueste NVIDIA Nemotron 3 Nano-Modell, Robotertraining, visuelle Sprachmodelle, Feinabstimmung von KI-Modellen mit zwei DGX Spark-Systemen, Genomik und Finanzanalyse behandeln.

Sobald DGX Station später in diesem Jahr verfügbar ist, werden weitere Playbooks für Entwickler hinzugefügt, die den Einstieg in die NVIDIA GB300-Systeme erleichtern können.

Support für NVIDIA AI Enterprise-Software ist ab sofort für DGX Spark- und GB10-Systeme von Herstellerpartnern verfügbar. NVIDIA AI Enterprise ermöglicht Bibliotheken, Frameworks und Microservices für die Entwicklung von KI-Anwendungen und die Installation von Modellen sowie Operatoren und Treiber für die GPU-Optimierung. Es ermöglicht eine schnelle und zuverlässige KI-Entwicklung und Bereitstellung von KI-Anwendungen. Die Lizenzen werden voraussichtlich Ende Januar verfügbar sein.

Verfügbarkeit

DGX Spark und GB10-Systeme von Herstellerpartnern sind bei Acer, Amazon, ASUS, Dell Technologies, GIGABYTE, HP Inc., Lenovo, Micro Center, MSI und PNY erhältlich.

DGX Station wird ab Frühjahr 2026 von ASUS, Boxx, Dell Technologies, GIGABYTE, HP Inc., MSI und Supermicro erhältlich sein.

Erfahren Sie in diesem technischen Blog mehr über DGX Spark.

Siehe Hinweise zu Softwareproduktinformationen.